Savoir

Le savoir est défini habituellement comme un ensemble de connaissances ou d'aptitudes reproductibles, acquises par l'étude ou l'expérience.

Définitions

En français, les termes de connaissances et de savoir sont employés alors que, par exemple, l'anglais utilise knowledge dans tous les cas. Ce décalage a une origine ancienne puisque le mot provient du latin sapere, verbe qui employé intransitivement indiquait une entité qui possédait une saveur. Il n'y avait donc alors pas de référence au moindre processus cognitif. Ce n'est qu'au Moyen Âge qu'émergea le sens actuel après avoir transité par une forme figurée désignant une personne en quelque sorte « informée ». À partir de cette époque, le fait de savoir fut considéré comme une attestation ou garantie de sagesse, association qu'on retrouve de nos jours sous la forme de la confusion traditionnelle entre le savoir et l'intelligence ; des oppositions telles que « tête bien pleine » et « tête bien faite » rappelant que les choses ne sont pas si simples.

Tout comme savoir et connaître ne s'emploient pas dans les mêmes contextes, on distingue savoir et connaissance :

- Le savoir : Pour Littré (1877), ce terme ne s’employait qu’au singulier et était défini comme « Connaissance acquise par l'étude, par l'expérience1 ». Le Trésor de la langue Française informatisé (TLFi) amplifie cette définition : « Ensemble des connaissances d'une personne ou d'une collectivité acquises par l'étude, par l'observation, par l'apprentissage et/ou par l'expérience 2. »

- La connaissance : connaissance d’une langue, d’une discipline. Ce terme s’emploie généralement au pluriel : connaissances usuelles, connaissances pratiques, base de connaissances, etc.

- Savoir et connaissance s’opposent au domaine de la croyance.

Le savoir se distingue par divers traits d'un ensemble de connaissances en particulier par la dimension qualitative : l'acquisition d'un savoir véritable suppose un processus continu d'assimilation et d'organisation de connaissances par le sujet concerné, qui s'oppose à une simple accumulation et rétention hors de toute volonté d'application. Au niveau individuel le savoir intègre donc une valeur ajoutée en rapport avec l'expérience vécue et de multiples informations contextuelles. Chaque personne organise et élabore son savoir en fonction de ses intérêts et besoins ; la composante consciente et volontaire de cette élaboration s'appelle la métacognition. La plupart des « savoirs » individuels sont naturellement utiles à l'action, à sa performance, sa réussite : « Savoir, c'est pouvoir ! ». C'est aussi sur des mises en situation que reposent les meilleures évaluations du savoir alors que des tests basés sur la seule restitution d'informations ne garantissent pas sa qualité et par conséquent sa valeur. De même, le savoir se rend plus visible et pratique sous le nom de « savoir-faire ». Les savoirs les plus intellectuels reposent sur l'appropriation ou création de concepts, en parallèle avec le développement des « savoirs scientifiques » ou de la philosophie. La notion de "savoir-être", quant à elle, utilisée notamment dans le champ de la formation des adultes renvoie aux attitudes et comportements qu'un sujet met en œuvre pour s'adapter à un milieu.

Si le savoir est à l'origine une composante personnelle et individuelle, le concept s'étend naturellement à toute entité capable d'une capitalisation analogue de son expérience :

- les autres animaux et autres organismes « savants » ;

- les communautés ou groupes humains et donc l'humanité dans son ensemble ; on parle de « savoirs traditionnels », « savoirs spécialisés », « savoir de l'Humanité », etc. ;

- certains systèmes informatiques, sans que cela pose l'équivalence du savoir humain et du savoir de la machine nommée telle qu'il est mis en œuvre dans un système expert ;

Chaque communauté repose sur un savoir partagé ; c'est une composante de son identité. Le poids et la reconnaissance de ce savoir et donc du savoir présentent des formes variables, mais le sort de la communauté est généralement lié à la conservation de ce patrimoine immatériel. Au sein des sociétés et cultures, l'éducation a pour mission d'aider à l'appropriation du savoir collectif élémentaire, on parle ainsi d'acquisition d'un socle commun, l'enseignement complétant l'acquisition de connaissances et savoir-faire disciplinaires, pendant que la formation professionnelle est chargée de la transmission des savoirs professionnels.

Le savoir se présente donc généralement comme une valeur collective ; une ressource de nature immatérielle. De ce point de vue, laissant provisoirement de côté l'insaisissable dimension psychologique, cette valeur prend l'allure d'un bien et même d'un « bien économique ». On réifie donc cette réalité en la matérialisant dans le langage. On parle donc de :

- acquisition du savoir, accès au savoir, appropriation des savoirs ;

- transmission du savoir, échanges de savoirs, partage du savoir, circulation du savoir ;

- gestion du savoir (GS), maîtrise des savoirs, valorisation des savoirs.

Selon les époques et les cultures, la conservation du savoir et la transmission des connaissances s'appuient sur la communication orale et l'expression écrite. Des « entrepôts du savoir » sont créés et entretenus comme mémoire collective : bibliothèque, centres de documentation, etc.

Dans une certaine mesure, le savoir se transmet de manière informelle par la communication entre pairs ou interaction entre membres de statuts comparables. L'efficacité de la transmission étant pour une part fonction de la plasticité mentale de l'apprenant, elle-même fonction de son âge en particulier, la pédagogie étudie les conditions de ces transmissions entre novices et apprenants et leurs maîtres ou professeurs plus expérimentés ou plus savants. Selon Cristol (2018)3, les moyens numériques favorisent l'accès à une masse de données, un enrichissement et une circulation accélérée d'informations. Le savoir peut désormais être distingué entre d'une part savoir-stock, il s'agit d'un savoir validé, cumulé dans la durée, dument validé qui creuse un sillon disciplinaire et d'autre part un savoir-flux, il s'agit d'un savoir qui organise des liens qui se modifie rapidement dont la validité est constamment revue grâce à une circulation et des corrections rapides.

Gestion du savoir

La gestion du savoir (GS) a pour objectif la valorisation du savoir au sein d'une entreprise ou d'une organisation pour de meilleures performances. Elle se compose de pratiques diverses soutenant la création de savoirs, l'organisation du savoir collectif et les capacités de son exploitation par les personnels. Ce secteur a commencé à émerger en fin des années 1980 quand la quantité d'informations disponibles s'est avérée excéder les capacités de leur intégration par les organismes.

La gestion doit s'appuyer sur une « culture du savoir » partagée par la communauté et rester en phase avec cette dimension. « Rétention d'informations », « culte du secret », etc., sont des réflexes qui doivent parfois être modérés avant tout autre objectif. D'un certain point de vue, la GS est à la Connaissance, ce que l'Information est au système d'information de l'entreprise. Les facteurs humains, sociaux doivent toujours être pris en considération pour une bonne compréhension de la démarche et la reconnaissance de sa légitimité : c'est l'ensemble de la structure qui doit se penser comme « organisation apprenante ». Le savoir doit être perçu comme la possibilité de prestations ou de produits de qualité supérieure.

La gestion du savoir s'attache d'abord à expliciter le « capital intellectuel » des employés en association avec la « mémoire » organisationnelle. Les investigations et initiatives nécessaires doivent valoriser simultanément la place du savoir de chacun au sein de l'activité. Cela comprend :

- la mise en formes explicites de savoir-faire implicites. On se demandera en particulier quel est le déficit de la « mémoire organisationnelle » en cas d'absence ou de départ de tel ou tel employé. On peut parler de « savoir instable ».

- le recensement de multiples formes de compétence restées méconnues, sans se restreindre au secteur d'activité ou au cadre professionnel. Cela rejoint naturellement les démarches de validation des acquis professionnels et la détermination des parcours de formation. On peut parler de « savoir méconnu » plutôt que de « savoir caché » (qui relèverait plutôt des secrets professionnels et apparentés).

À ce stade, les grandes lignes d'une « cartographie du savoir » peuvent déjà être déployées ; la confrontation de cette carte avec la structure et fonctionnement de l'organisation peut permettre de relever ses faiblesses du point de vue de la valorisation du savoir (gestion des ressources humaines).

Alors, selon l'organisme concerné, une dynamique de création de savoirs doit être progressivement mise en place. Cette démarche pourra à un autre niveau accompagner ou soutenir toutes les modalités de changement de l'organisation (logique de projet, évolutions et mutations). Il s'agit donc de développer et consolider les formes de communication (échanges d'idées) et de créativité en les orientant vers la réalisation de ressources pérennes réutilisables.

La gestion du savoir peut être ainsi conçue comme la zone commune à la veille informationnelle et à l'information et communication internes. La complexité de ces processus requiert des investissements dans les technologies de l'information. L'informatique est employée aux différents stades de la valorisation du savoir, en particulier dans la gestion et la communication de la documentation et autres mises en forme des connaissances.

Une fois les savoirs inventoriés et préservés dans un processus d'accroissement continu, il faut garantir l'accès de tous à ces ressources, pour finalement vérifier et soutenir leur usage dans les pratiques effectives. Pour les grandes organisations au moins, le modèle global peut être une espèce de « marché du savoir » où l'offre et la demande devraient coïncider et satisfaire à tout moment les besoins des producteurs et des consommateurs. Cette adéquation ne doit pas être uniformisante et façonner un employé moyen, mais au contraire se préoccuper notamment de l'accessibilité d'un même savoir à des « clients » très divers.

Comme il a été dit, les facteurs psychologiques, les composantes relationnelles, ne doivent jamais être sous-estimées à tous les stades de la valorisation du savoir, au risque de voir surgir des réactions et des désordres imprévus bien contraires à l'intention première. Il ne faut pas oublier que l'élaboration ou acquisition d'un savoir véritable demande du temps, de la disponibilité et donc avant toute chose une réelle motivation ; motivation qui peut se nourrir du gain d'autonomie qu'apporte à toute personne une meilleure gestion de son savoir propre. On n'oubliera pas non plus que l'organisation peut n'avoir aucun intérêt à maintenir certains savoirs. Comme tout acteur social, elle peut « ne rien vouloir savoir » de certains de ses propres défauts, ou de son propre passé. Elle peut vouloir ignorer qu'elle n'est pas seulement une machine à profit, mais aussi partie prenante d'une société d'êtres humains qui ne sont ni des clients ni des employés, mais des concitoyens. Mais il est sans doute inhérent à toute institution humaine de ne bâtir ses propres savoirs qu'en en refusant d'autres.

Les transmissions des savoirs

Les savoirs sont distingués de multiples manières par l’anthropologie sociale et culturelle. On peut distinguer notamment les savoirs implicites et explicites, les savoirs techniques (savoir-faire) et les savoirs idéels (mythes et cosmogonies), les savoirs partagés et les savoirs réservés.4

Cependant la transmission des savoirs n'équivaut pas à la réplication de ceux-ci car elle est toujours œuvre d'interprétation, contribuant ainsi (délibérément ou non) au changement individuel, social et politique.

Les formes du savoir

- Tradition orale,

- Encyclopédie,

- Atlas,

- Formulaire,

- Nomogramme, Abaque,

- Traité. C'est un ouvrage à but pédagogique qui présente un savoir d'une manière qui se veut complète et exhaustive. Selon les domaines, les traités peuvent prendre des formes particulières :

- En architecture - Traité d'architecture,

- En littérature - Traité (littérature).

Notes et références

- [1] [archive]

- « Savoir : Définition de Savoir » [archive], sur www.cnrtl.fr (consulté le )

- Denis Cristol, Dictionnaire de la formation, apprendre à l'ère numérique, Paris, ESF,

- Patrick Pion, Nathan Schlanger, « Introduction dans Apprendre » [archive], sur Cairn.info, (consulté le )

Bibliographie

- Nicolas Adell, Anthropologie des savoirs, Armand Colin, 2011

Articles connexes

- Autoformation

- Capital-savoir

- Compétence

- Économie du savoir

- Gestion des connaissances

- Psychologie de l'apprentissage

- Savoir-être

- Savoir-faire

- Société de la connaissance

- Valeur-savoir

Liens externes

- Politique de gestion des connaissances du Canada [archive]

- Le savoir en ligne [archive]

- Revue scientifique sur les savoirs et la pédagogie en formation d'adulte [archive]

Compréhension

« Comprendre » redirige ici. Pour l'émission de radio, voir Comprendre (Europe 1).

La compréhension (également appelée noûs) est un processus psychologique lié à un objet physique ou abstrait tel que la personne, la situation ou le message selon lequel une personne est capable de réfléchir et d’utiliser des concepts pour traiter cet objet de manière appropriée. La compréhension est la relation entre celui qui connaît et l’objet de la compréhension. Elle implique des capacités et des dispositions par rapport à un objet de connaissance suffisant afin de produire un comportement intelligent1. Une compréhension constitue la limite d’une conceptualisation. Comprendre quelque chose signifie l’avoir conceptualisée dans une certaine mesure.

Réfléchir demande généralement une capacité cognitive et intellectuelle, au-delà du fait qu’elle soit accessible par tout être «bien constitué ». Une réflexion poussée, qui nécessite une culture et une information, permet d’aboutir à des résultats sensés et cohérents. Certains troubles de l’attention peuvent altérer la concentration et la réflexion profonde. Certaines personnes utilisent leur réflexion pour aboutir à des raisonnements jugés stupides, leur réflexion est considérée comme superficielle et inutile.

Exemples

- On ne peut comprendre le temps que si l’on est en mesure de prédire et de fournir une explication de certaines de ses caractéristiques, etc.

- Un psychiatre peut comprendre l’anxiété des autres s’il parvient à connaître leurs angoisses et leurs causes pour ensuite leur donner des conseils utiles sur la manière d’y faire face.

- Une personne peut comprendre un ordre si elle connaît son émetteur et ses attentes, et si la personne se fait comprendre par tous (voir numéro 4).

- On peut comprendre un raisonnement, un argument ou un langage si l’on peut reproduire de manière consciente le contenu de l’information véhiculée par le message.

- On peut comprendre un concept mathématique si ce dernier permet de résoudre des problèmes, y compris les problèmes nouveaux.

La compréhension comme modèle

Gregory Chaitin, un célèbre informaticien, avance que la compréhension est un type de compression de données2. Dans son essai The Limits of Reason (Les limites de la raison), il affirme que comprendre quelque chose signifie être capable de comprendre un ensemble de règles qui l’explique. Par exemple, nous sommes capables de comprendre pourquoi le jour et la nuit existent car nous disposons d’un modèle simple : la rotation de la Terre. Ce modèle désigne une quantité phénoménale de données : variation de luminosité, de température et composition atmosphérique de la Terre. Nous avons compressé de nombreuses informations en utilisant un simple modèle de prédiction. De la même façon, nous comprenons que le nombre 0,33333… équivaut à un tiers. Une quantité importante de mémoire a été nécessaire pour représenter le nombre d’une première façon. La deuxième façon, elle, permet de produire toutes les données de la première représentation mais utilise beaucoup moins d’informations. Chaitin affirme que la compréhension est cette faculté à compresser des données.

Les composants de la compréhension

La cognition et l’affect

La cognition est le processus par lequel les entrées sensorielles sont transformées. L’affect renvoie à l’expérience des sentiments ou des émotions. La cognition et l’affect constituent la compréhension.

Des perspectives religieuses

Dans le catholicisme et l’anglicanisme, la compréhension représente l’un des dons du Saint-Esprit.

Notes et références

- Carl Bereiter, « Education and mind in the Knowledge Age » [archive].

- Gregory Chaitin, « The Limits Of Reason », Scientific american, (lire en ligne [archive])

Voir aussi

Bibliographie

- (en)Gregory Chaitin, « The Limits Of Reason », Scientific american, (lire en ligne [archive])

- Miguel Espinoza, El evento de entender, Universidad Austral de Chile, 1978.

- Isabelle Kalinowski, « Compréhension (sociologie) », Encyclopædia Universalis, consulté le 7 mars 2020, [lire en ligne [archive]]

Articles connexes

- Écoute active, Empathie

- Chambre chinoise

- Communication

- Épistémologie

- Sens (linguistique)

- Noûs

- Perception

- Pensée

- Constructivisme (psychologie)

- Neuropédagogie

Liens externes

Conscience

Pour les articles homonymes, voir Conscience (homonymie).

Cet article concerne les aspects psychologiques et philosophiques de la conscience. Pour les études neuroscientifiques, voir Conscience (biologie).

Le terme de conscience peut faire référence à au moins quatre concepts philosophiques ou psychologiques1 :

- Au sens psychologique, elle se définit comme la « relation intériorisée immédiate ou médiate qu'un être est capable d’établir avec le monde où il vit et avec lui-même »[réf. nécessaire]. En ce sens, elle est fréquemment reliée, entre autres, aux notions de connaissance, d'émotion, d'existence, d'intuition, de pensée, de psychisme, de phénomène, de subjectivité, de sensation, et de réflexivité. Ce sens correspond par exemple à l'allemand Bewusstsein et à l'anglais consciousness, et en français à la locution plus précise d'« état de conscience ». La conscience est « cette capacité de nous rapporter subjectivement nos propres états mentaux »2 ;

- Au sens moral, elle désigne la « capacité mentale à porter des jugements de valeur moraux […] sur des actes accomplis par soi ou par autrui ». En ce sens, elle correspond par exemple à l'allemand Gewissen et à l'anglais conscience ;

- En tant que critère de catégorisation conceptuel, elle représente le trait distinctif caractérisant l'humanité d'un sujet et par extension la spécificité caractérisant l'ensemble éponyme de ces sujets ;

- Par métonymie, elle désigne la totalité formée par l'ensemble des représentations d'un sujet conscient, tout au moins de ses représentations conscientes.

Si ces propositions de définition font de la conscience une expérience prégnante pour tout être humain, elle n'en reste pas moins, comme le souligne par exemple André Comte-Sponville « l'un des mots les plus difficiles à définir »3. Cette difficulté se heurte en effet à la problématique d'une conscience tentant de s'auto-définir. En effet, la possibilité qu'aurait une faculté de se discerner elle-même ne fait pas consensus, et connaît même des détracteurs dans des courants de pensée fort éloignés. Un proverbe bouddhiste formule l'adage selon lequel « un couteau ne peut se couper lui-même »4, tandis qu'Auguste Comte assure que personne « ne peut [...] se mettre à la fenêtre pour se regarder passer dans la rue ».

Polysémie

Le terme de conscience peut être distingué en plusieurs catégories :

- la conscience serait un phénomène mental caractérisé par un ensemble d'éléments plus ou moins intenses et présents selon les moments : un certain sentiment d'unité lors de la perception par l'esprit ou par les sens (identité du soi), le sentiment qu'il y a un arrière-plan en nous qui « voit », un phénomène plutôt passif et global contrairement aux activités purement intellectuelles de l'esprit, actives et localisées, et qui sont liées à l’action (par exemple la projection, l’anticipation, l’histoire, le temps, les concepts…). La conscience est « ce qui voit » sans s’assimiler à ce qui est vu, c'est ce qui intègre à chaque instant en créant des relations stables entre les choses, à l'image des réseaux neuronaux. La conscience est un lieu abstrait, car impossible à localiser quelque part dans le corps, qui apparaît à chaque instant au moment exact où fusionnent les perceptions des sens et de l'esprit, l’écran sur lequel se déroulent toutes les activités intellectuelles de l’esprit, en grande partie imaginaires (les représentations mentales : conscience du monde, des autres, du moi…), mais efficaces à leur manière, ainsi que la vie émotionnelle ;

- la conscience morale, respect de règles d'éthique, sens unique du terme jusqu'au XVIIe siècle ;

- la conscience en tant que substrat de l'existence, dans certaines conceptions de la spiritualité.

Représentations

Le premier sens renvoie à ce qui permet une représentation, même très simplifiée, du monde et des réactions par rapport à celui-ci. Il est alors question de « conscience du monde ». C’est celle qui est évoquée dans des expressions comme « perdre conscience », ou, à l'inverse, « prendre conscience ».

Chez les humains, les recherches récentes sur plusieurs périodes de l'histoire montrent l'importance du concept de représentation : par exemple Georges Duby (sur le bas Moyen Âge), Jean Delumeau (sur la Renaissance), et sur un plan plus épistémologique, les recherches de Michel Foucault relatives à l'épistémè. On évoquera également le philosophe allemand Arthur Schopenhauer qui a consacré une grande partie de sa philosophie à l'étude de cette faculté représentative des animaux et, en particulier, de l'homme dans son œuvre principale et magistrale, Le Monde comme volonté et comme représentation.

La conscience est un « fait » au sens où René Descartes, dans les Méditations métaphysiques, laisse entendre que « l'âme est un rapport à soi ». L'examen de la conscience suppose ainsi le doute méthodique comme la façon première d'entrer dans un rapport à soi non erroné. Dans un sens plus « individualiste », la conscience peut aussi correspondre à une représentation, même très simplifiée, de sa propre existence. Il est alors question de conscience de soi, ou de conscience réflexive (en anglais self-awareness). Elle est attribuée au moins aux grands singes hominoïdés comme le sont par exemple les humains, les chimpanzés, les gorilles et les orangs-outans. Il semble assez raisonnable de l'étendre aussi aux dauphins et aux éléphants qui disposent de capacités cognitives et affectives avancées. La conscience dans ce second sens, implique celle du premier, puisque « se connaître », signifie nécessairement « se connaître dans ses rapports au monde » (y compris d’autres êtres potentiellement doués de conscience). L'inverse en revanche est disputé.

Chaque personne éveillée est consciente, ayant l'expérience de son entourage ; endormie ou morte elle devient inconsciente[incompréhensible].

La conscience de soi est bien illustrée en médecine, surtout au niveau individuel. C'est en effet une des fonctions vitales qui permet de réagir aux situations, de bouger et de parler spontanément. Plus généralement, l’état de conscience (de la conscience pleine au coma profond) est déterminé par l’état neurologique du patient[évasif].

Formes minimales

Au niveau de la conscience du monde, les choses peuvent se montrer plus complexes, en impliquant un ensemble de phénomènes liés au contexte sociologique, politique, économique. Le degré minimal de conscience du monde semble celui où on[Qui ?] a tout simplement quelque chose à dire sur le monde. Un simple capteur de présence possède un début de représentation du monde (présence, absence). Encore faut-il pour l’intégrer dans un schéma de conscience que cette information soit utilisée en aval par quelque chose (déclencheur d'alarme, etc.)[incompréhensible].

La conscience de soi, comme la conscience du monde (René Dubos dirait « agir local / penser global ») n'est jamais complète[réf. souhaitée]. Une question qui s'en déduit — puisque toutes sont incomplètes — est « quel est le degré minimal de conscience de soi imaginable ? ». Descartes y répond par son célèbre « Je pense, donc je suis ». Les sciences cognitives s'intéressent à détailler le sens « opérationnel » de cette phrase[évasif] (voir Antonio Damasio, Daniel Dennett…)[réf. souhaitée].

La formule de Socrate, tirée de l'oracle de Delphes : « connais-toi toi-même », montre qu'une mauvaise connaissance de soi a un impact sur la connaissance du monde et réciproquement — puisque nous faisons partie du monde. En fait, la conscience de soi désigne la conscience de phénomènes particuliers reliés au concept de soi.

Notion de culture

La notion de conscience du monde pourrait aussi être rapprochée de celle de culture, en tant que cette dernière est un système de représentation. Le mot culture est souvent perçu en langue française dans une acception individuelle avec une connotation « intellectuelle » (ce terme n'étant pas toujours perçu positivement), encore qu'il existe des sens collectifs : culture d'entreprise, culture française, culture de masse…

En allemand, les deux sens sont donnés par des mots différents : Bildung5 et Kultur6.

Aspects

Pluralité de manifestations

Outre les deux sens principaux déjà vus, le concept de conscience a de nombreux sens ou manifestations que l’on peut s’efforcer de distinguer, bien que dans certains cas, ces différences soient surtout des différences de degrés :

- la conscience comme sensation : tout être doué de sensibilité, voire un système automatique, peut être dit, dans une certaine mesure, « conscient » de son environnement, puisqu'il répond à des stimuli ; c'est ce qu'on désigne sous le nom de « conscience du monde » ;

- la conscience spontanée, sentiment intérieur immédiat ; certains philosophes de l’Antiquité (par exemple les Stoïciens) parlent de « toucher intérieur »7 (voir l'article Qualia) ;

- on peut distinguer une étape supérieure, en signifiant par le mot conscience un état d’éveil de l’organisme, état différent du précédent en ce sens qu’il ne comporte pas de passivité de la sensibilité (cf. en anglais, le mot wakefulness, vigilance, alerte, ou awareness) ; en ce sens, il n’y a pas de conscience dans l’état de sommeil profond ou dans le coma ;

- conscience de soi : la conscience est la présence de l’esprit à lui-même dans ses représentations, comme connaissance réflexive du sujet qui se sait percevant. Par cette présence, un individu prend connaissance, par un sentiment ou une intuition intérieurs, d’états psychiques qu’il rapporte à lui-même en tant que sujet. Cette réflexivité renvoie à une unité problématique du moi et de la pensée, et à la croyance, tout aussi problématique, que nous sommes à l’origine de nos actes ; ce dernier sens est une connaissance de notre état conscient aux premiers sens. Le domaine d’application est assez imprécis et il comporte des degrés : s’il s’agit d’une conscience claire et explicite, les enfants qui ne parlent pas encore ne possèdent sans doute pas la conscience en ce sens ; s’il s’agit d’un degré moindre de conscience, d’une sorte d’éveil à soi, alors non seulement les enfants peuvent être considérés comme conscients mais aussi certains animaux ;

- un autre sens du mot conscience a été introduit par le philosophe Thomas Nagel : il s’agit de la conscience pour un être de ce que cela fait d’être ce qu’il est ;

- la conscience comme conscience de quelque chose (conscience transitive, opposée à l’intransitivité du fait d’être conscient). Cette conscience renvoie à l’existence problématique du monde extérieur et à notre capacité de le connaître ;

- la conscience intellectuelle, intuition des essences ou des concepts ;

- la conscience phénoménale, en tant que structure de notre expérience ;

- à un degré conceptuellement plus élaboré peut exister ou non la « conscience morale », définissable comme la compréhension et la prise en charge par l'individu des tenants et aboutissants de ses actes pour la collectivité et les générations futures.

Dans l’ensemble de ces distinctions, on peut noter une conception de la conscience comme savoir de soi et perception immédiate de la pensée, et une autre comme sentiment de soi impliquant un soubassement obscur et un devenir conscient qui sont, en général, exclus de la première conception. La conscience morale, quant à elle, désigne le sujet du jugement moral de nos actions. De cette conscience-là, on dit aux enfants qu'elle nous permet de distinguer le bien du mal. Voir plus bas.

Questions fondamentales

Il existe de nombreuses théories qui s’efforcent de rendre compte de ce « phénomène ».

Ce sujet fait l’objet des travaux de Daniel Dennett, Antonio Damasio et Jean-Pierre Changeux, ainsi que des sciences cognitives. Le modèle du spectateur cartésien est remis en cause car, comme le fait remarquer Daniel Dennett, on ne peut expliquer la conscience par la conscience : expliquer exige que l’explication ne fasse pas appel elle-même à une compréhension de ce qu’on souhaite justement expliquer (« To explain means to explain away »). En d’autres termes, on n’aura expliqué la conscience que lorsque cela aura été fait en termes ne faisant pas intervenir le mot ni le concept de « conscience ». Sinon, on tombe dans un argument circulaire (voir l’article : sophismes). On remarquera que Daniel Dennett, remet en cause le modèle du « spectateur cartésien » avec une explication elle-même de type « circulaire ».

Il semble que ces questions soient à mettre en rapport avec le cogito de Descartes, replacé dans son contexte, et avec la notion de représentation du monde. Descartes conçut sa philosophie en réaction au modèle géocentrique, incarné par les « aristotéliciens » et la scolastique décadente de son époque, et en fonction du modèle héliocentrique qui émergeait avec les observations faites par Galilée (voir Dialogo sopra i due massimi sistemi del mondo, 1633).

Disciplines concernées

Dans le langage courant, le concept de conscience peut être opposé à l’inconscience, à l’inattention, à la distraction, au divertissement, etc. Lorsqu'il s'agit de l'étudier, c'est avant tout la philosophie qui a été et est concernée. Outre la médecine, l’étude de la conscience concerne plusieurs disciplines, comme la psychologie, la psychanalyse, la psychiatrie, la philosophie de l'esprit et la philosophie de l'action. Elle est aussi liée au langage (verbal ou non), donc à la philosophie du langage.

Philosophie

La psychanalyse

Sigmund Freud, Essai de psychanalyse

La psychanalyse distingue, à la suite de Sigmund Freud, la conscience de l'inconscient8. Dans la première topique établie par Freud, la conscience est l’une des trois instances composant l'appareil psychique, les deux autres étant le préconscient et l’inconscient. Ainsi pour Freud, la conscience n'est pas l'essence du psychisme, elle n’en est qu'une partie et ignore de nombreux phénomènes qui sont de l’ordre de l'inconscient. Ceux-ci ne peuvent être amenés à la conscience que dans le cadre de la cure psychanalytique, à travers la prise de conscience du refoulé9.

Méditation

Les pratiquants de la méditation cherchent à accéder à une prise de conscience (de la conscience), voire à des états modifiés de conscience10,11,12. C'est une méthode pour entrer en soi et s'interroger soi-même dans la perspective de mieux se connaître et de vivre une expérience subjective intérieure personnelle.

Histoire

Il n’existe aucun concept strictement comparable à celui de conscience dans la philosophie de la Grèce antique : l'être de Parménide (voir ontologie) pourrait s'en rapprocher.

Chez certains auteurs romains, le mot latin prend une dimension morale dérivée du droit, exprimant le fait de se prendre soi-même pour témoin.

Ce n’est qu’au XVIIe siècle que le terme apparaît dans les langues européennes13.

Le concept de conscience n’a été isolé de sa signification morale qu’à partir de John Locke, dans son Essai sur l'entendement humain (1689). Avant lui le mot conscience n’a jamais eu le sens moderne14. En particulier, Descartes ne l’emploie quasiment jamais15 en ce sens, bien qu’il définisse la pensée comme une conscience des opérations qui se produisent en nous (les Principes de la philosophie, 1644). Le Petit Robert attribue à Malebranche (1676) la définition de conscience comme « connaissance immédiate de sa propre activité psychique », alors que l'Essai de Locke date de 1689.

C’est le traducteur de Locke, Pierre Coste, qui a introduit l’usage moderne du mot conscience (donc en français, mais le sens du mot consciousness était bien sûr tout aussi nouveau), associé à l’idée d’un soi-même dont la conscience exprime l’identité.

Caractéristiques

La conscience présente certains traits caractéristiques qui peuvent notamment inclure : rapport à soi, subjectivité (la conscience que l'individu possède de lui-même est distincte de celle d’autrui), la structure phénoménale, la mémoire, la disponibilité (ou liberté de la conscience à l’égard des objets du monde), la temporalité, la sélectivité, l’intentionnalité (toute conscience est conscience de quelque chose, est tournée vers autre chose qu’elle-même16) et l’unité ou synthèse de l’expérience.

Conscience de soi

La conscience s’accompagne de souvenirs, de sentiments, de jugements, de sensations et de savoir que nous rapportons à une réalité intérieure que nous nommons moi. Cette conscience est appelée conscience de soi, et est structurée par la mémoire et l’entendement. Elle est en ce sens une unité synthétique sous-jacente à tous nos comportements volontaires. Les éléments qu’elle contient, souvenirs, sentiments, jugements, dépendent d’un contexte culturel, ce qui fait de la conscience de soi une réalité empirique changeante et multiple. L’unité et la permanence du moi ne sont donc pas garanties par l’unité, peut-être seulement nominale, de la conscience.

Le cogito cartésien (« je pense donc je suis ») tend à exprimer l'état de conscience de celui qui s'exprime. Autrement dit le sujet, disant « Je » exprime une conscience de lui-même (Ego), en termes de savoir (raisonnement - entendement). Le « Je pense » est interactif. Il implique et nécessite, pour être exprimé, la conscience de soi. La conclusion d'être pourrait dès lors paraître redondante. Toutefois, elle vient exprimer l'état et la relation sensitive. « Je pense donc je suis » peut donc se décliner en « Je sais que je ressens donc j'existe ». C'est aussi la faculté de douter de sa propre existence qui « atteste » de cette existence même.

Rapport en première personne

L’introspection est une méthode d’investigation de la conscience qui vient, généralement, la première à l’esprit. C’est un fait que nous pensons tous avoir un accès privilégié à notre esprit, accès dont la conscience serait l’expression. Mais l’investigation de notre vie mentale n’est certainement pas suffisante pour élaborer une théorie étendue de la conscience : « on ne peut pas, disait Auguste Comte, se mettre à la fenêtre pour se regarder passer dans la rue ». Le sujet ne peut en effet s’observer objectivement puisqu’il est à la fois l’objet observé et le sujet qui observe, d’autant que la conscience se modifie elle-même en s’observant. Toute psychologie impliquerait donc d’examiner la conscience à la troisième personne, même s'il faut alors se demander comment il est possible d’observer ainsi la conscience de l’extérieur.

Le stade du miroir (se reconnaître dans un miroir) est souvent, considéré comme une étape essentielle de la conscience de soi, réservé à l'humain. Mais si ce stade est atteint vers l'âge d'un an et demi à deux ans chez l'homme, certains chimpanzés expérimentés, certains autres grands singes, éléphants, dauphins, perroquets et pies, sont capables de se reconnaître dans un miroir, comme l'a montré le test du miroir en éthologie17.

Courant

L’idée de conscience de soi pose le problème de l’unité d’un sujet, d’un moi ou d’une conscience. On peut très généralement distinguer deux types d’hypothèses :

- la conscience est l’expression d’une unité interne — le je du je pense ; cette unité peut être comprise de différentes manières :

- la conscience n’est qu’une liaison d’agrégats d’impressions (Hume) qui peut être décrite comme une suite plus ou moins cohérente de récits concernant un sujet purement virtuel — le moi. Aussi, « quand mes perceptions sont écartées pour un temps, comme par un sommeil tranquille, aussi longtemps je n’ai plus conscience de moi et on peut dire vraiment que je n’existe pas » (Hume, Traité de la nature humaine, I). Selon cette thèse, le moi est autre.

Conscience du monde extérieur

Selon Husserl, qui reprend un concept médiéval, toute conscience est conscience de quelque chose. Cela suppose que la conscience soit un effort d’attention qui se concentre autour d’un objet. Cette concentration est structurée par l’expérience ou par des catégories a priori de l’entendement, structures que l’on considère parfois comme les fondements de toute connaissance du monde extérieur. Dans l’idéalisme moderne la conscience est ainsi la source et l’origine de la science et de la philosophie.

À la question de savoir quelles relations la conscience entretient avec la réalité en général, une description phénoménologique répond que celle-ci a une structure spatiale et temporelle, structure qui est une organisation des concepts qui concernent notre expérience du monde et nous-mêmes en tant qu’acteurs de ce monde.

Conscience morale

C’est le sens premier du mot conscience, trouvé chez Cicéron et Quintilien, et qui, dans la langue française, reste sans concurrence jusqu’au XVIIe siècle (voir section histoire). La conscience psychologique est souvent évoquée comme une « lumière », la conscience morale comme une « voix » : si la première « éclaire », la seconde « parle ». La conscience morale désigne en effet le sentiment intérieur d’une norme du bien et du mal qui « dit » comment apprécier la valeur des conduites humaines, qu’il s’agisse des nôtres ou de celles d’autrui. C’est aussi le démon que Socrate suivait et qui l'amena à être condamné par la cité.

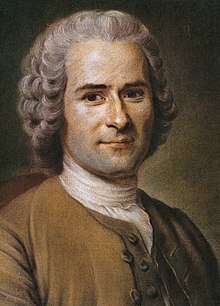

Rousseau

Cette « voix » de la conscience, qui se fait entendre dans l’individu est pourtant, selon Rousseau, la même en tout homme. Malgré la diversité et la variabilité des mœurs et des connaissances, elle est « universelle » : elle est en chacun des individus la « voix de la nature », car selon Émile : « quoique toutes nos idées nous viennent du dehors, les sentiments qui les apprécient sont au-dedans de nous, et c’est par eux seuls que nous connaissons la convenance ou disconvenance qui existe entre nous et les choses que nous devons respecter ou fuir » (Émile, Livre IV).

Tel un instinct, mais pourtant signe de notre liberté, elle ne trompe jamais, pour peu qu’elle soit réellement écoutée : « Conscience ! Conscience ! Instinct divin, immortelle et céleste voix ; guide assuré d’un être ignorant et borné, mais intelligent et libre ; juge infaillible du bien et du mal, qui rends l’homme semblable à Dieu, c’est toi qui fais l’excellence de sa nature et la moralité de ses actions ; sans toi je ne sens rien en moi qui m’élève au-dessus des bêtes, que le triste privilège de m’égarer d’erreurs en erreurs à l’aide d’un entendement sans règle et d’une raison sans principe » (Émile, Livre IV).

Alain

Selon Alain, la conscience est « le savoir revenant sur lui-même et prenant pour centre la personne humaine elle-même, qui se met en demeure de décider et de se juger. Ce mouvement intérieur est dans toute pensée ; car celui qui ne se dit pas finalement : « que dois-je penser ? » ne peut pas être dit penseur. La conscience est toujours implicitement morale ; et l’immoralité consiste toujours à ne point vouloir penser qu’on pense, et à ajourner le jugement intérieur. On nomme bien inconscients ceux qui ne se posent aucune question d’eux-mêmes à eux-mêmes » (Définitions, dans Les Arts et les Dieux).

Pour Alain, il n’existe donc pas de morale sans délibération, ni de délibération sans conscience. Souvent la morale condamne, mais lorsqu’elle approuve, c’est encore au terme d’un examen de conscience, d’un retour sur soi de la conscience, de sorte que « toute la morale consiste à se savoir esprit », c’est-à-dire « obligé absolument » : c’est la conscience et elle seule qui nous dit notre devoir.

Origine de la conscience morale ?

La question demeure cependant de savoir quelle origine attribuer à la conscience morale. Car si pour Rousseau « les actes de la conscience ne sont pas des jugements, mais des sentiments » (ibid.), il n’en sera plus ainsi pour Kant, qui considérera au contraire la conscience morale comme l’expression de la raison pratique − et encore moins pour Bergson, qui verra en elle le produit d’un conditionnement social, ou pour Freud, qui la situera comme l’héritière directe du surmoi (Malaise dans la civilisation, VIII)

Théories

Les questions de savoir ce qui caractérise la conscience, quelles sont ses fonctions et quels rapports elle entretient avec elle-même ne préjugent pas nécessairement du statut ontologique qu’il est possible de lui donner. On peut, par exemple, considérer que la conscience est une partie de la réalité qui se manifeste dans des états de conscience tout en étant plus qu’une simple abstraction produite à partir de l’adjectif « conscient ». Cette thèse réaliste (au sens de la philosophie médiévale, voir réalisme et nominalisme) n’a plus beaucoup de défenseurs de nos jours. L’une des raisons en est que l’investigation purement descriptive ne rend pas nécessaire ce genre d’hypothèses réalistes.

- La conscience s'étudie par ses manifestations. Une école de pensée, le behaviorisme, se propose d'ailleurs de n'étudier que les manifestations elles-mêmes, sans chercher à poser l'hypothèse d'une conscience sous-jacente et bien difficile à définir.

- Dualisme

- Physicalisme

- La conscience du point de vue matérialiste, comme François Kammerer, Conscience et matière, 201919.

- L’approche de Timothy Leary avec ses 8 circuits.

- La conscience consciente d'elle-même dont témoigne l'écrivain Stephen Jourdain.

- Autres théories cognitives (Douglas Hofstadter, Daniel Dennett, Antonio Damasio, Gerald Edelman, Giulio Tononi).

- Les théories quantiques de la conscience de Roger Penrose (1989, 1994) et Stuart Hameroff (1998).

et même des approches totalement physiques (matérialisme scientifique), comme celle de Jean-Pierre Changeux, selon lequel les percepts et les concepts constituent des entités physiques se traduisant par des connexions physiques et logiques de neurones, qu’il entend mettre en évidence ; c’est déjà le cas pour les percepts. Dans cette démarche, Stanislas Dehaene poursuit les travaux de recherche sur la Théorie de l'espace neuronal global, dans Le Code de la conscience, 2014.

Le concept de conscience n'est donc plus exclusivement utilisé par la philosophie ou la psychologie, des chercheurs d'autres disciplines comme la sociologie ou l'anthropologie s'intéressent à ce concept en lui donnant d'autres sens, à partir souvent de résultats d'enquêtes ou d'observations directes et participantes. Par exemple, des chercheurs sous la direction d'Alfredo Pena-Vega et de Nicole Lapierre ont étudié l'émergence d'une conscience européenne chez des jeunes vivant en Poitou-Charente.

Des disciplines telles que la neurologie s'intéressent elles aussi au concept de conscience. À ce titre, les altérations de conscience par exemple dans le cadre d'un accident vasculaire cérébral permettent de mieux appréhender ce concept. Ainsi, la vision aveugle dans le cadre d'un accident vasculaire occipital consécutif à l'occlusion du tronc basilaire, permet d'expérimenter une vision inconsciente des objets. Le patient parvient à éviter des objets d'une façon qu'il qualifie d'intuitive donc inconsciente.

Religions

Christianisme

L'encyclique Veritatis splendor de Jean-Paul II (1993) accorde une grande importance à la conscience dans la recherche de la vérité :

- « Le droit à la liberté religieuse et au respect de la conscience dans sa marche vers la vérité est toujours plus ressenti comme le fondement des droits de la personne considérés dans leur ensemble20. »

Bouddhisme

La philosophie bouddhique étudie elle aussi la conscience, vijñāna et en analyse les différentes formes et fonctions. Il s'agit alors de l'un des constituants de la personne, skandhas, distinct de la perception, samjñā ; cependant, si vijñāna est traduit par conscience, et que le terme désigne bien une connaissance, le concept bouddhiste ne recouvre pas exactement la conscience telle qu'elle est thématisée dans la pensée occidentale.

Hindouisme et védisme

Au cours des siècles, la conscience n'était pas définie systématiquement de la même façon sur le sous-continent indien. La notion de « conscience pure » dans les théories dérivées des textes de l'hindouisme, est comme un « état libéré », libéré du karma, libéré du samsara. Elle peut être comprise comme un substrat de l'existence individuelle. Pour certains hindouistes, plus le chemin du yogi avance dans la méditation, plus sa conscience devient grande. Le problème de la dualité de l'univers entre l'individuel et le Tout, c'est-à-dire Dieu se pose aussi21. Dieu dans le Brahmanisme et l'Hindouisme peut être l'être suprême Brahman, transcendant (Tat) ou immanent (Sat-Chit-Ananda) dont la triplicité est l’existence-conscience-félicité. c'est encore la Trimurti de Brahma-Vishnou-Shiva. La Mandukya Upanishad donne quatre états de conscience : éveillé, dormant, rêvant et n'étant qu'un avec le Brahman22. Ce quatrième état de conscience, ou Turiya, qui veut dire quatrième en sanskrit, est au-delà des états de veille, de rêve et de sommeil dont il peut être considéré comme la source à l'origine de trois fleuves, ou encore illustré comme l'image du moyeu d'une roue à trois branches. Pour Aurobindo Ghose qui réunit spiritualité et matérialisme dans une vision évolutionniste de l'humanité, l'émergence d'une conscience de vérité qu'il appelle la conscience supramentale23 peut contribuer à l'évolution d'une nouvelle conscience sur terre. Pour Jean Gebser la conscience supramentale de Sri Aurobindo est la même que la conscience intégrale qu'il décrit dans sa vision de l'évolution de la conscience24.

Médias

Plusieurs représentations allégoriques et médiatiques de la conscience sont référencées dans la mythologie, la littérature et le cinéma.

Cinéma

- Jiminy Cricket, un cricket, qui est la conscience de Pinocchio dans le dessin animé de Walt Disney (1940), adapté du conte pour enfants de l´écrivain italien Carlo Collodi.

Littérature

Crime et Châtiment de Dostoïevski évoque une forme d'auto justice. La punition qu'inflige la conscience de Raskolnikov à lui-même est pire que la prison ou le camp de travail.

Le vrai châtiment de Raskolnikov n’est pas le camp de travail auquel il est condamné, mais le tourment qu’il endure tout au long du roman. C'est le même thème qu'aborde Victor Hugo dans son poème La Conscience avec l'idée qu'on n'échappe pas à sa conscience.

- Minos qui juge Socrate symbolise en partie la conscience dans « rêveries d'un païen mystique » de Louis Ménard25.

- L'œil de Caïn, dans « La Conscience » de Victor Hugo, poème publié dans le recueil La légende des siècles26.

Notes et références

- Christian Godin, Dictionnaire de philosophie

- Sciences Humaines. No spécial « Le cerveau en 12 questions », en date de

- André Comte-Sponville, Dictionnaire philosophique, PUF, , p. 127

- Conscience [archive], publié par Le Centre Vimalakirti, lieu consacré à la pratique de diverses méditations bouddhiques.

- (de) Voir l'article en allemand.

- (de) Voir l'article en allemand.

- Daniel Heller-Roazen, Une archéologie du toucher, Seuil, coll. « La Librairie du XXIe siècle », , 432 p. (présentation en ligne [archive])

- Sigmund Freud, Métapsychologie, Ed. Presses Universitaires de France, 2010, (ISBN 2-13-057957-4)

- Roland Chemama (dir.) et Bernard Vandermersch (dir.), Dictionnaire de la psychanalyse, Paris, Larousse, , 4e éd., 602 p. (ISBN 978-2-03-583942-8), p. 108-109

- J.G. Henrotte, P. Etevenon, G. Verdeaux. Les états de conscience modifiés volontairement. La Recherche, 1099-1102, 29, décembre 1972, Paris

- Pierre Etevenon et Bernard Santerre, États de conscience, Sophrologie et Yoga, Éditions Tchou, 2006

- Les états de conscience modifiés [archive].Pierre Etevenon. 3emillénaire, N°127, 14-23, printemps 2018.

- Conscience & cerveau : la nouvelle frontière des neurosciences, De Boeck Supérieur, , 340 p. (ISBN 978-2-8041-3766-3, lire en ligne [archive]), p. 78

- John Locke (trad. et dir. Etienne Balibar), Identité et Différence : L'Invention de la conscience, Seuil, 1998

- Voir Natalie Depraz, La conscience. Approches croisées, des classiques aux sciences cognitives (cf. Bibliographie), ch.1, § 1.3, où elle recense les (très rares) occurrences chez Descartes des termes conscientia, conscius esse, et conscience en français ; elle conclut que [chez Descartes] « on a moins affaire à une philosophie de la conscience qu'à une philosophie de la vérité certaine et du fondement (…) ».

- « la conscience n’a pas de dedans, elle n’est rien que le dehors d’elle-même. » (Sartre)

- Voir Ces drôles d'oiseaux [archive], Documentaire de Volker Arzt et Immanuel Birmelin (Allemagne, 2006, 2 × 43 min), diffusé sur Arte le 5 septembre 2006

- What is consciousness ? [archive]

- Kammerer 2019

- Jean-Paul II, Veritatis Splendor, no 53, lire en ligne sur le site du Vatican [archive]

- Dictionnary of Hinduism par W.J. Johnson publié par Oxford University Press, page 86, (ISBN 9780198610250)

- The A to Z of Hinduism par B.M. Sullivan publié par Vision Books, pages 56 et 57, (ISBN 8170945216)

- Sri Aurobindo. La synthèse des Yoga. Le Yoga de la perfection de Soi, tome 3, Buchet Chastel, 1995.

- Jean Gebser, The Ever-Present Origin, Traduction de l'allemand de Noel Barstad et Algis Mickunas, Athens: Ohio University Press, 1985, 1991

- Voir le document .

Annexes

Bibliographie

Textes classiques

- Henri Bergson, Essai sur les données immédiates de la conscience

- Henri Bergson, « La conscience et la vie » in L'Énergie spirituelle

- René Descartes, Discours de la méthode

- René Descartes, Méditations métaphysiques

- René Descartes, Les Principes de la philosophie

- Maurice Halbwachs, Les Cadres sociaux de la mémoire, Paris, 1926, Albin Michel (nouvelle édition)

- Maurice Halbwachs, La Mémoire collective, Paris, 1950, Albin Michel (nouvelle édition)

- Sigmund Freud, L'Interprétation des rêves (1900), PUF 2005 (ISBN 2-13-052950-X) (notamment dans le chapitre VII)

- Emmanuel Kant, Critique de la raison pure

- Gottfried Wilhelm Leibniz, Nouveaux essais sur l’entendement humain

- John Locke, Essai sur l'entendement humain (en particulier le chapitre 27). Voir John Locke, Identité et différence. L’invention de la conscience

- Philip Low, Déclaration de Cambridge sur la conscience

- Karl Marx et Friedrich Engels, L'Idéologie allemande

- Baruch Spinoza, Éthique

- Rudolf Steiner, Philosophie de la liberté ; traduit de l'allemand par Jean-Luc Evard et Joseph Morsel

Études

- Étienne Balibar. Introduction à John Locke : Identité et Différence. L'Invention de la conscience, édition bilingue, Seuil, Paris, 1998. Voir aussi « Identité et différence selon Étienne Balibar » [archive], par Françoise Badelon, in Multitudes, mis en ligne le 21 juin 2003)

- Claude Berrou et Vincent Gripon, Petite mathématique du cerveau (Une théorie de l'information mentale), 2012, Odile Jacob

- Michel Bitbol, Physique et Philosophie de l'Esprit, Champs-Flammarion, 2005

- Pierre Buser, Neurophilosophie de l'esprit (ces neurones qui voudraient expliquer le mental), 2013, Odile Jacob

- David Chalmers, The Conscious Mind: In Search of a Fundamental Theory (1996). Oxford University Press. hardcover: (ISBN 0-19-511789-1), paperback: (ISBN 0-19-510553-2)

- Jean-Pierre Changeux, L'homme neuronal, 1991, Pluriel

- Jean-Pierre Changeux et Paul Ricœur, Ce qui nous fait penser (La nature et la règle), 2001, Odile Jacob

- Antonio Damasio, Le Sentiment même de soi, 2002, Odile Jacob

- Antonio Damasio, Spinoza avait raison

- Stanislas Dehaene, Le Code de la conscience, Paris, Odile Jacob, coll. « Sciences », , 427 p. (ISBN 978-2738131058, lire en ligne [archive]),

- Jean Delacour, Conscience et cerveau

- Daniel Dennett, La Conscience expliquée

- Natalie Depraz, La Conscience. Approches croisées, des classiques aux sciences cognitives, Armand Colin, 2001 (ISBN 2-200-26370-8)

- Gerald Edelman, Giulio Tononi, Comment la matière devient conscience

- Gerald Edelman, Plus vaste que le ciel, 2004

- Gerald Edelman, Biologie de la conscience, 2000, Odile Jacob

- Laurent Fedi (2008). Piaget et la conscience morale. PUF, Paris (ISBN 978-2-13056-725-7)

- Daniel Heller-Roazen, Une archéologie du toucher (2012), Le Seuil, Paris

- François Kammerer, Conscience et matière : Une solution matérialiste au problème de l'expérience consciente, Paris, Éditions matériologiques, coll. « Sciences et philosophie », , 533 p. (ISBN 9782373612141, lire en ligne [archive]).

- Kittsteiner, Heinz D. La Naissance de la conscience morale, Paris, Cerf, 1997 ; traduit de l'allemand par Jean-Luc Evard et Joseph Morsel

- Karl Popper, Le soi et son cerveau, 2018, Éditions rue d'Ulm

- Stéphane Sangral, Des dalles posées sur rien, 2017, Éditions Galilée

- John Searle, Le Mystère de la conscience, Éditions Odile Jacob, 1999 (ISBN 978-2738107466). Réflexion sur les conceptions concernant la conscience de Francis Crick, Gerald Edelman, Roger Penrose et Daniel Dennett.

Articles connexes

- Conscience de soi (Hegel)

- Conscience de classe

- Conscience morale

- Conscience collective

- Liberté de conscience

- Bicaméralité - théorie controversée autour de l'apparition de la conscience

- État modifié de conscience

- Méditation

- Inconscient

- Introspection

- Problème difficile de la conscience

- Science et conscience

- Stade du miroir et test du miroir

- Vijñāna

- Turiya

- État de conscience (secourisme)

- Empathie spatiale

Liens externes

- Ressources relatives à la recherche

- :

- Ressources relatives à la santé

- :

- (en) Medical Subject Headings

- (no + nn + nb) Store medisinske leksikon

-

Notices dans des dictionnaires ou encyclopédies généralistes

- La conscience est-elle le gage d'un bien commun ? [archive]

Écouter la série de cinq leçons consacrée à« La Conscience. Des neurones à l'esprit » [archive]dispensée au Collège Belgique (2009-2010).

Écouter la série de cinq leçons consacrée à« La Conscience. Des neurones à l'esprit » [archive]dispensée au Collège Belgique (2009-2010).- Vers une cartographie cérébrale des états de conscience ? [archive]

Apprentissage

L’apprentissage est un ensemble de mécanismes menant à l'acquisition de savoir-faire, de savoirs ou de connaissances. L'acteur de l'apprentissage est appelé apprenant. On peut opposer l'apprentissage à l'enseignement dont le but est de dispenser des connaissances et savoirs, l'acteur de l'enseignement étant l'enseignant.

Pour la psychologie inspirée du béhaviorisme, l’apprentissage est vu comme la mise en relation entre un événement provoqué par l'extérieur (stimulus) et une réaction adéquate du sujet, qui cause un changement de comportement qui est persistant, mesurable, et spécifique ou permet à l’individu de formuler une nouvelle construction mentale ou réviser une construction mentale préalable.

L’historien Philippe Ariès dans son ouvrage L’enfant et la vie familiale sous l’Ancien Régime (Paris, Seuil, 1975), insiste sur l’importance qu’il convient d’attribuer à l’apprentissage. Il force les enfants à vivre au milieu des adultes, qui leur communiquent ainsi le savoir-faire et le savoir-vivre. Le mélange des âges qu’il entraîne lui paraît un des traits dominants de notre société, du milieu du Moyen Âge au XVIIIe siècle2.

La psychologie du développement étudie les changements, acquisitions et pertes, de la vie embryonnaire à la mort. L'apprentissage est un concept important étudié par cette discipline.

On a découvert en 2016 que l'apprentissage pouvait exister même dans certains organismes unicellulaires3.

Définition de l'apprentissage

L'apprentissage consiste à acquérir ou à modifier une représentation d'un environnement de façon à permettre avec celui-ci des interactions ou des relations efficaces ou de plus en plus efficaces.

L’apprentissage est un « changement dans le comportement d’un organisme résultant d’une interaction avec le milieu et se traduisant par un accroissement de son répertoire. L’apprentissage se distingue des changements comportementaux survenant à la suite de la maturation de l’organisme qui constituent eux aussi des enrichissements du répertoire mais sans que l’expérience, ou l’interaction avec le milieu, ait joué un rôle significatif »4.

En béhaviorisme, on distingue généralement les conditionnements « classique » (type pavlovien) et « opérant » tel celui mis en place 20 ans après les expériences de Pavlov par le psychologue Skinner.

(voir également les différents processus d'apprentissage des adultes)

Apprentissage, acquis et inné

La plupart des organismes pluricellulaires sont capables d'apprendre et de se souvenir, par des processus émergents. Certains unicellulaires montrent aussi une certaine capacité d'apprentissage.

- L'aspect fonctionnel en a d'abord été théorisé par Pavlov, fait intervenir des concepts déjà étudiés par Bayes et Laplace.

- L'aspect structurel est encore étudié par les neurosciences (voir par exemple Jean-Pierre Changeux). On est dans ce cas encore loin de comprendre des modèles aussi complexes que le cerveau humain. On commence (2008) à modéliser des systèmes perceptifs très simplifiés (voir réseau de neurones) que l'on « éduque » par des méthodes encore assez empiriques et à identifier des gènes directement impliqués dans le processus d'apprentissage et de la mémoire. On a d'abord cru qu'un groupe identifié de gènes contrôlait à la fois le conditionnement passif (Pavlov) et le conditionnement opérant. Des expériences faites sur des drosophiles génétiquement modifiées testées pour leurs capacités d'apprentissage dans un simulateur de vol laissent maintenant penser que les deux formes d'apprentissage dépendent de groupes différents de gènes et que l'apprentissage comportemental dépend de gènes qui n'étaient pas connus comme impliqués dans l'apprentissage. De plus, dans ce cas, les processus pavloviens inhibaient l'apprentissage comportemental. Des gènes qu'on pourrait qualifier de liés aux comportements répétitifs qui entrent en jeu dans l'apprentissage pourraient être aussi liés à des phénomènes de dépendance5,6.

- l'apprentissage peut être individuel et/ou collectif (ex : technique particulières de chasse en groupe chez certains carnivores et réponses groupées de proies, ou apprentissage collaboratif chez l'Homme)

- Chacun d'entre nous étant le produit de son hérédité et de son milieu, on peut parler d'intrication personnelle et collective entre inné et acquis, celle-ci constituant ce que nous nommons l'expérience individuelle et de groupe.

Apprentissage, pédagogie et neuroscience

Certains phénomènes très aléatoires, se prêtent mal à l'apprentissage : ce que l'on croit savoir est alors une illusion, mais le sujet ne s'en rend pas compte. Ce « faux savoir » peut être très structurant pour l'environnement, notamment si les générations futures ont été conditionnées pour s'en imprégner.

L'apprentissage peut être un phénomène spatio-temporel individuel ou collectif (c'est une population qui apprend, éventuellement sur plusieurs générations chez l'humain notamment ; c'est une part de la culture commune et partagée). La distinction entre l'individuel et le collectif dépend aussi de l'échelle utilisée : un neurobiologiste, considère métaphoriquement l'apprentissage individuel chez l'être humain ou tout autre être vivant comme un apprentissage collectif effectué par sa population de neurones.

Des recherches récentes utilisant la caméra à positons indiquent que les mêmes zones cérébrales s'activent lors de l'observation d'une chose et de sa pratique (voir neurones miroirs). Outre l'éclairage que donne cette découverte sur le mimétisme comportemental des vulgarisateurs comme Robert Winston en infèrent qu'observer serait déjà « un peu » pratiquer.

L'expérience consistant à mettre deux chatons à deux bouts d'un tourniquet (l'un ayant l'usage de ses pattes pour rendre l'ensemble mobile et l'autre non) montre cependant7 qu'à expérience visuelle égale la psychomotricité ne s'acquiert que là où la vue est directement liée à l'action motrice.

Les théories de l'apprentissage

Distinguer les théories de l'apprentissage

Les « cinq questions définitives pour distinguer les théories de l'apprentissage », par Mergel8 (en distinguant la section apprentissage, ¶ 1) fournit un cadre pour organiser les différentes théories :

- Comment l'apprentissage se produit-il ?

- Quels facteurs influent sur l'apprentissage?

- Quel est le rôle de la mémoire ?

- Comment le transfert du savoir se produit-il ?

- Quelles pratiques d'apprentissage sont mieux expliquées par cette théorie? (¶ 2)

Tableau des théories d'apprentissage

Le tableau ci-dessous analyse les différentes théories d'apprentissage9.

|

Domaines |

|||||

|

Comment l'apprentissage se fait |

Black box - comportement observables : l'objectif principal |

Structurés, de calcul |

Signification sociale, créés par chaque apprenant (personnelle) |

Réflexion sur l'expérience personnelle |

Distribué dans un réseau, social, technologiquement renforcée, reconnaître et interpréter les modèles |

|

Facteurs d'influence |

Schémas Existants, les expériences précédentes |

Engagement, participation, social, culturel |

La motivation, les expériences, les relations |

Diversité du réseau, la force des liens, le contexte de survenue |

|

|

Rôle de la mémoire |

La mémoire est le câblage réel d'expériences répétées, où la récompense et la punition sont les plus influents |

Encodage, le stockage, la récupération |

La connaissance précédente remixée au contexte actuel |

Détient l'évolution du concept du soi |

Modèles adaptifs, représentatifs de l'état actuel, existant dans les réseaux |

|

Comment le Transfert se produit |

Stimulus, réponse |

Duplication de structures de connaissance des « connaisseurs » |

Socialisation |

La facilitation, la transparence |

Connexion aux (ou ajout de) nœuds et agrandissement du réseau (social / conceptuel / biologique) |

|

Pratiques d'apprentissage expliqué par cette théorie? |

(Task-Based Learning) Apprentissage basé sur des tâches. |

Raisonnement, des objectifs clairs, la résolution de problèmes |

Auto-dirigé, autonome |

Reconnaissant le problème de société qu'est la vision de l'école comme Institution disciplinaire, les mouvements libertaires, anarchistes, ou punks, mettent également en avant d'autres théories de l'apprentissage :

- École libre

- Edupunk

- Apprentissage libre (en)

- Éducation démocratique

- Éducation libertaire

- Éducation holistique

- Summerhill School

- l'éducation Centré sur les élèves

- Instruction à la maison

- Démocratie des étudiants

- Éducation populaire

- Learning commons, e-learning centers

- Travail collaboratif

- Edgar Morin dans sa vision coconstructiviste, parle de Réforme de l’éducation10

- Des écoles sont formées d'après les causeries de Jiddu Krishnamurti11, se rapprochant de l'humanisme, et d'une éducation holistique.

Méthodes d'apprentissage

Apprentissage par imitation

Le plus courant : il suppose de la part de l'enfant la valorisation d'un modèle et la volonté de le posséder, de le prendre. C'est par l'imitation que se font tous les apprentissages « spontanés » de la petite enfance: parole, gestes, mimiques, etc., ainsi que ceux de la dimension esthétique des activités: ton, grâce, style, manière, etc. Le rôle du pédagogue est de montrer l'exemple ou de proposer des modèles, sans devoir faire appel à la rationalité expérimentale et à sa systématisation. Abandonné par la pédagogie scolaire, il reste utilisé pour l'enseignement de tous les arts, qu'il s'agisse de l'équitation, du violon, de la cuisine, du dessin ou de la danse.

Apprentissage par induction

L'induction est une forme d'apprentissage qui fonctionne très bien lorsqu'elle est bien encadrée. Elle consiste à créer une théorie, une loi, à partir d'observations, d'expériences12. Par exemple, si j'observe une seringue remplie d'air que je peux compresser et étirer, j'en induirai que l'air, et les gaz, sont compressibles. Par contre, si un enfant observe une plume et une roche qui ne tombent pas à la même vitesse dans l'air, il induira que les objets lourds tombent plus vite, ce qui est faux. Il faut donc bien encadrer les sujets lorsque l'on utilise cette méthode. Elle se révèle très efficace car elle suscite des interrogations, ce qui établit un maximum de connexions dans notre cerveau, car nous apprenons avec ce que nous savons déjà13.

Apprentissage par association

On associe un stimulus nouveau à un mécanisme déjà appris, pour créer un nouveau savoir (exemple : si une réaction à une odeur est déjà apprise, on peut faire apprendre la même réaction à un son en faisant systématiquement précéder l'odeur par le son).

Apprentissage par essais et erreurs

Il s'agit de la méthode essai-erreur. Le sujet est mis en situation, on ne lui donne aucun mode d'emploi (parfois même pas la condition de succès ou d'élimination). Pour fonctionner correctement, il faut que la solution soit assez facile à trouver, compte tenu de ce que le sujet sait déjà.

Pour apprendre des choses complexes, il faut donc s'appuyer sur l'apprentissage par association pour enchaîner des situations de difficulté croissante et permettant de nombreuses répétitions. Cela rend cet apprentissage coûteux. Mais c'est le seul qui fonctionne encore quand la solution doit être découverte, on parle alors de démarche heuristique.

- On peut distinguer une variante mentale : le sujet ne fait pas vraiment certains essais, mais utilise seulement des résultats virtuels, imaginaires, pour trier les essais qui valent la peine d'être faits : les expériences de pensée sont utilisées pour raisonner sur des phénomènes que nous ne pouvons expérimenter dans la réalité (cf. Einstein se demandant ce qu'il verrait s'il se déplaçait à la vitesse de la lumière). Cette construction imaginaire peut aller très loin, jusqu'à constituer un cadre théorique complet : beaucoup de mathématiciens depuis la plus haute antiquité imaginent ainsi « se déplacer » dans un univers de concepts mathématiques qui existerait indépendamment des humains (conception dite « platonicienne », dont Alain Connes est un des représentants célèbres).

- On peut également distinguer deux stratégies : la suppression des causes d'échec (détecter les événements conduisant à l'élimination) et la recherche des facteurs de succès (détecter les événements caractéristiques du succès). Dans le premier cas, il faut être capable de supporter l'échec pour frôler la limite ; cela permet de bien délimiter le domaine, et le sujet est plus à même de transposer à d'autres situations similaires mais différentes ; mais le risque est, par association, de faire l'apprentissage de l'échec plutôt que de la réussite…

À noter : une variante où, au lieu d'un seul individu faisant quantité d'essais, c'est un grand nombre d'individus qui font chacun un essai seulement. C'est l'apprentissage par sélection (ou criblage) qui est la méthode des populations vivantes pour apprendre à vivre (processus de sélection naturelle).

Apprentissage par explication

On explique au sujet, oralement ou par écrit, ce qu'il doit savoir (exemple : un manuel de secourisme). C'est le principe des cours magistraux. On parle souvent de transmissif dans ce cas.

Apprentissage par répétition

On fait faire au sujet ce qu'il doit apprendre, d'abord passivement, puis de plus en plus activement, jusqu'à ce qu'il puisse faire et refaire seul les opérations.

Apprentissage combiné

C'est le plus efficace, et il est très utilisé en matière d'enseignement de savoir-faire professionnel, car il combine les modalités précédentes : le sujet est mis en situation (en commençant par les plus simples), on lui montre quelquefois les bons gestes en lui expliquant les principes d'action ; on le laisse ensuite se perfectionner par une répétition de moins en moins supervisée.

Apprentissage par immersion

Les langues s'apprendraient mieux en situation d'immersion totale. Par exemple, lorsque les cours ne sont donnés que dans la langue à apprendre et que le professeur ne parle avec les élèves que dans leur langue d'immersion. À défaut, il est conseillé de passer une année ou deux dans un pays parlant la langue souhaitée afin de mieux saisir les différences d'expressions orales et écrites. De plus, en se débrouillant seul, on apprendrait plus facilement à comprendre la langue, les coutumes et la culture d'un pays.

Enquête sur les acquis fondamentaux

En 2004, les résultats d'une étude de l'OCDE menée dans quarante pays ont montré que les jeunes français étaient dans la moyenne en mathématiques. Cette enquête du Programme international pour le suivi des acquis (P.I.S.A.), cherchait à évaluer les compétences en mathématiques des élèves de 15 ans : la France arrivait en seizième position avec 511 points, c'est-à-dire onze points au-dessus de la moyenne des pays de l'OCDE. L'enquête portait sur environ 4 500 élèves par pays. En 2001, une enquête similaire révélait que la France se trouvait en milieu de classement pour la maîtrise de l'écrit et de la lecture : 4,2 % des jeunes français ne savaient pas lire correctement, contre 6,3 % en 2004.

Recherches, applications et usages

- L'éthologie étudie les comportements d'apprentissage : le rôle de l'intelligence, les comportements d'adaptation et de survie concernent beaucoup d'espèces animales.

- L'Éducation Nationale (En France) dispose d'un vaste réseau de recherche sur la pédagogie. Les comportements d’apprentissage caractéristiques - auto-verbalisation systématique, questionnement répétitif–semblent difficiles à mettre en œuvre dans les classes de l’école primaire.

- Il y a un renouvellement de la réflexion sur l’apprentissage grâce aux réflexions des chercheurs sur la transmission de connaissances aux robots : dans un système expert, l’expert doit acquérir de nouvelles connaissances, enrichir son expérience, enregistrer les diagnostics qui ne marchent pas.

- L’enseignement à distance et l’usage de didacticiels ont obligé à formaliser les conditions d’un apprentissage de bonne qualité : possibilité de réaction immédiate, répétabilité, capacité de retraitement de l’information.

Autres dimensions de l'apprentissage

L'apprentissage est considéré dans les conceptions modernes d'ingénierie des connaissances, comme l'une des composantes clés de la performance collective des organisations, dans des communautés de pratique.

Quelques théories et sous-catégories d'apprentissage :

- apprentissage automatique, Apprentissage en ligne, Apprentissage collaboratif Apprentissage par le plaisir ;

- la pédagogie de la Gestion mentale issue des travaux d'Antoine de la Garanderie ;

- apprentissage moteur, outil, technique ;

- Cognition, apprenance, Apprentissage supervisé, le tutorat, Contrat d'apprentissage ;

- enseignement des langues étrangères, Lecture ;

- méthode scientifique ;

- phases de l'apprentissage ;

- constructivisme, Psychologie génétique, Psychologie cognitive, Sociologie cognitive, Sociologie de l'éducation ;

- apprentissage des émotions14 ;

- debugging ;

- apprentissage par le jeu.

Besoin

Le besoin se définit comme étant l’ensemble de tout ce qui est nécessaire à un être et/ou qui s’impose à tous. Selon Jacques Lapointe, dans son article intitulé « L’analyse des besoins d’apprentissage », on retrouve régulièrement le besoin dans les conversations selon les sujets traités et les circonstances qui l’entourent. Le besoin est associé au corporel, au spirituel au physiologique, au monétaire, à l’artificiel. De plus, on lie ce concept facilement aux concepts d’apprentissage.

On l’utilise indifféremment pour rendre compte des notions de désir, de manque et d’insuffisance. Parlant de cette notion de manque rattaché au besoin, il y a Kaufman qui détaille un peu plus. Il l’a présente dans un modèle « d’analyse d’écart », il définit le besoin comme étant « l’écart mesurable entre ce qui est et ce qui devrait être ». Le concept de besoin est intéressant du fait de sa simplicité apparente. Comme le souligne Fenouillet « le besoin repose sur une idée principale qui est facilement compréhensible des spécialistes comme des non spécialistes de la question : le manque ».

Besoins d'apprentissage

Cette notion, se rapporte à l’idée de « au quoi apprendre ou au quoi enseigner », c’est-à-dire ce que l’on peut transmettre, qui est une notion épistémique. Apprendre remet en cause l’identité des gens, ça bouscule les acquisitions antérieures. Le fait de penser les apprenants en termes de besoin peut faciliter pour un professionnel de l’éducation le dépassement d’obstacles dans la construction de médiations éducatives et pédagogiques. Kern Dominique, dans son article intitulé « les besoins d’apprentissage spécifique au grand âge », analyse les besoins d’apprentissage des personnes de grand âge, c’est-à-dire des personnes vieillissantes. Kern propose une conceptualisation du besoin d’apprentissage, dans la formation scolaire, les besoins d’apprentissage sont définis selon les injonctions des pouvoirs publics dans les programmes scolaires et celles des entreprises dans la formation continue. Et même dans le contexte de personnes plus âgées, on retrouve aussi ces mécanismes. L’on peut parvenir à l’identification des besoins par au moins deux chemins : d’un côté par le recensement auprès des apprenants réels ou potentiels et, d’un autre, par une construction théorique plus ou moins étayée scientifiquement.

Le besoin d’apprentissage n’est pas seulement que le cas d’individu mais une notion en lien avec les injonctions sociales.

En somme, nous pouvons souligner que celui qui apprend à toujours besoin d’apprendre, afin d’apprendre à ceux qui apprennent

Notes et références

- Source PLoS Biol 5(5): e139. doi:10.1371/journal.pbio.0050139

- René Dinkel, « L'Encyclopédie du patrimoine (Monuments historiques, Patrimoine bâti et naturel - Protection, restauration, réglementation - Doctrines - Techniques - Pratiques)», Notice Apprentissage p. 391 et Chapitre VIIII Les mécanismes assurant la qualité des travaux p. 225 à 243, Paris (éditions Les Encyclopédies du patrimoine), septembre 1997 (ISBN 2-911200-00-4)

- CNRS : Un organisme unicellulaire capable d'apprendre [archive]

- Richelle, 1991, p. 49

- Vidéo (en anglais) [archive] du Prof. Brems expliquant le protocole expérimental des expériences d'apprentissages de drosophiles génétiquement modifiées

- Communiqué de presse du 2008 07 28 (Freie Universität Berlin) et article « Wie Fliegen Erfahrungen speichern », du Tagesspiegel 2008 08 29

- Encyclopédie Time-Life Le Monde des sciences.

- Instructional Design & Learning Theory [archive], Brenda Mergel

- George Siemens, Qu'est-ce que Connectivisme? [archive],

- Le manifeste pour la métamorphose du monde [archive] dit « L'Appel de Bora Bora » lancé par Edgar Morin, Pierre F. Gonod et Paskua le 21 mars 2009

- Krishnamurti FoundationTrust [archive]

- Gérard Fourez, 2004, Apprivoiser l’épistémologie, Bruxelles, Éditions De Boeck Université, 183 p.

- Frank Smith, 1979, La compréhension et l’apprentissage, Montréal, Éditions HRW, 277 p.

- (en) Barrett, Lisa Feldman, How emotions are made : The secret life of the brain, PAN Books, , 448 p. (ISBN 978-1-5098-3752-6 et 1-5098-3752-3, OCLC 995768849)

Voir aussi

Bibliographie

Ouvrages

- Jean-Pierre Astolfi, L’école pour apprendre, Paris, Col. Pédagogies E.S.F.

- Bernadette Aumont et Pierre-Marie Mesnier, L’acte d’apprendre, Paris, P.U.F.

- Nadine Bednarz et Catherine Garnier, Construction des savoirs (Obstacles et conflits), Agence d’Arc,

- Benjamin S. Bloom, Caractéristiques individuelles et apprentissages scolaires, Paris, Nathan, 1979,

- Blandine Bril, Apprentissage et contexte, Revue Intellectica n°35 : 251-268,

- (en) F. Büchel et J.-L. Paour, Assessments of learning and development potential : theory and practices, Journal européen de psychologie de l’éducation, N° 5 (Numéro spécial),

- Denis Chevallier, Savoir faire et pouvoir transmettre, Paris, Édition de la MSH,

- Bernard Charlot, Du rapport au savoir (Éléments pour une théorie), Paris, Col. Anthropos, Économica,

- Stéphane Ehrlich, Apprentissage et mémoire chez l’homme, P.U.F., 1975,

- Robert M.Gagné, Les principes fondamentaux de l’apprentissage, Montréal, Holt, Rinehart & Winston,

- André Giordan et Gérard de Vecchi, L’origine des savoirs, Neuchâtel/Paris, Delachaux et Niestlé,

- Charles Hadji, Penser et agir l’éducation (De l’intelligence du développement au développement des intelligences), Paris, E.S.F.