Renouvellement de l'air intérieur

Le renouvellement de l'air des volumes intérieurs est une nécessité dans le domaine de l'architecture et de la conception des habitacles. Ses enjeux concernent le confort, la santé, mais aussi les économies d'énergie.

La ventilation peut être passive ou mécaniquement assistée.

Pourquoi aérer

Il est nécessaire de renouveler l'air intérieur d'une pièce habitée, d'un habitacle de véhicule, d'un élevage, d'une serre, tout d'abord parce que la respiration animale (ou végétale, la nuit) y diminue la quantité de dioxygène disponible, augmente la quantité de gaz carbonique et d'humidité. Ce renouvellement est particulièrement important dans les enceintes totalement fermées (station spatiale, véhicule spatial, sous-marin, certains avions, etc.).

L'air intérieur étant de deux à cinq fois plus pollué que l'air extérieur, l'aération fréquente est plus que nécessaire. La présence des polluants à la ville ou à la campagne est plus faible le matin et le soir, l'aération est donc recommandée à ces moments de la journée1.

Sources de pollution

- La présence d'humains ou d'animaux, voire de certaines plantes génère des odeurs qui peuvent être désagréables (sueur, gaz, etc.) ; d'autant plus si la promiscuité et la température sont élevées.

- L'activité humaine génère aussi de l'humidité (expiration, transpiration générant de la condensation sur les parois froides, condensations qui favorisent les moisissures );

- L'air intérieur se charge rapidement de particules, gaz et microbes (éventuellement pathogènes ; Cf. flore bactérienne ou fongique), virus, etc. notamment dans certains endroits (toilettes, cuisines, salle de bains, locaux poubelle, etc.) ;

- Certaines activités humaines génèrent des gaz ou des odeurs (cuisine, cheminées).

L'« Institut de la Terre » (Earth Institute) de l'université Columbia estime2 qu'environ 1.5 million de personnes meurent chaque année dans le monde parce qu'elles sont exposées aux fumées, gaz et goudrons de foyer non fermé pour le chauffage ou la cuisine dans l'intérieur de leur logement (maison, hutte, tente, bidonville..)

- Les produits d'entretien, désinfectants ou produits divers utilisés pour la rénovation ou le travail peuvent être sources d'émanations gênantes à toxiques.

- Certaines activités génèrent des émanations dangereuses (risque toxique, corrosif, microbien ou d'explosion, avec dans le pire des cas Embrasement généralisé éclair ..) ;

- Les aménagements et matériaux modernes, notamment les colles de matières plastiques (moquettes, certains sols plastiques ou de linoléum, divers objets en plastique ou outils électroménagers, émettent des produits organiques volatils (POV), qui à long terme peuvent être toxiques (notamment cancérigènes ou reprotoxiques) ;

- Du radon peut s'accumuler dans les lieux fermés particulièrement dans les sous-sols et demi sous-sols d'où le radon s'infiltre dans les locaux occupés.

- La prolifération d'acariens peut générer des allergies chez les personnes allergiques (par contact avec leurs excréments).

Effets sur la santé

L’air intérieur peut être plus pollué que l’air extérieur. Cela peut entraîner des effets sur la santé selon le sexe, l’âge des personnes exposées, leur durée d’exposition ou encore le type de pollution. Certains polluants présents dans l’air intérieur sont suspectés par de nombreuses études scientifiques d’être allergènes, mutagènes, neurotoxiques, cancérigènes, reprotoxiques ou irritants. Selon l’Organisation mondiale de la santé (OMS), la pollution de l’air intérieur serait responsable de 2 millions de décès prématurés. Face à ce constat, des médecins de l'Association santé environnement France (ASEF) ont lancé une étude sur la pollution de l'air au sein des crèches3. Celle-ci a révélé l’importance du lieu de construction des crèches, de leur mode de construction et de leur ameublement.

Mauvaise aération fréquente

En théorie et en moyenne, on estime que l'air d'une maison ancienne se renouvelle en ½ heure, que celui d'une maison moderne non isolée se renouvelle en 1 heure, et que sans ventilation, l'air d'une maison bien isolée se renouvelle en 10 heures, mais ce n'est pas toujours le cas en réalité.

- Le sondage du Baromètre Santé-Environnement de 2007 en France a montré que 5,1 % des Français disent avoir bouché les orifices d’aération durant les 12 derniers mois.

Huit personnes sur dix (84,1 %) disent aérer quotidiennement leur logement en hiver et 60,5 % se disent équipées d’une ventilation mécanique contrôlée (VMC). Concernant l’entretien des appareils de chauffage et conduits d’aération : 69,2 % des personnes possédant une cheminée disent l'avoir fait ramoner au cours de l’année précédente, et 70,8 % de celles possesseurs d’appareils de chauffage utilisant une source combustible ont fait appel à un professionnel qualifié au cours des douze derniers mois pour vérifier leur état. - Une étude récente4,5 a porté sur la ventilation de 567 logements jugés représentatifs des 24 millions de résidences principales du pays. 50 % de ces logements dataient d’avant 1967, 1969 et 1982, dates des premières réglementations imposant une aération permanente minimale.

L’étude a montré que près de 20 % des logements réalisés après 1975 ne respectaient aucune de ces deux réglementations. De plus, l'étude a montré que la ventilation mécanique contrôlée (VMC) n’était pas plus efficace que la ventilation passive naturelle (ces 2 modes d’aération constituant l’aération de 70 % environ du parc étudié). 56 % des logements étudiés, en particulier ceux construits de 1969 à 1982, présentaient un débit total d'air insuffisant et ne respectant pas la loi.

Le taux de CO2 et le débit de renouvellement d’air nocturne ont été mesurés dans les chambres à coucher. Dans les logements datant d’après 1982, les débits étaient moindres et homogènes, et à peu près similaires pour tous les systèmes de ventilation sur l’ensemble du parc étudié (VMC ou avec ventilation naturelle).

L’OQAI a aussi montré que le fait d’ouvrir la nuit une porte ou une fenêtre d’une chambre y améliorait fortement le débit de renouvellement d’air nocturne, quel que soit le système de ventilation présent. Et des études antérieures avaient déjà montré qu'aérer une chambre la nuit avait peu d’effet sur les taux de formaldéhyde généré par les sources habituelles d'une maison, il faut donc parallèlement en diminuer les sources en utilisant des écomatériaux.

L'OQAI conduit aussi des études (en cours) sur les origines du formaldéhyde, et sur la relation entre ventilation, pollution et humidité.

Ces problèmes sont souvent exacerbés par l'isolation croissante des logements et par le temps croissant que nous passons dans les locaux et les habitacles de véhicules :

- L'isolation thermique se développe pour économiser l'énergie en évitant les fuites de chaleur dans les bâtiments à faible hauteur. Dans les édifices élevés (à plusieurs étages), la ventilation mécanique est d'autant plus nécessaire que les vitres y sont souvent scellées.

- La climatisation en circuit fermé se développe ; mais un minimum d'air extérieur doit être introduit dans le bâtiment.

- L'isolation phonique plus fréquente et souvent nécessaire, diminue aussi le renouvellement d'air qui se faisait naturellement dans les maisons anciennes, mal isolées ou avec cheminées.

- Enfin, les systèmes de climatisation consistant à évacuer les calories à l'extérieur peuvent être responsables de bulles de chaleur auto-entretenues (le climatiseur renvoie la chaleur à l'extérieur, ce qui réchauffe l'environnement et l'habitat s'il est mal isolé, ce qui force le climatiseur à fonctionner en entretenant un cercle vicieux), notamment dans les quartiers urbains denses ou les cours fermées. La climatisation contribue au phénomène d'îlot de chaleur urbain.

Solution

Dans les pays où ces problèmes ont été pris en compte, des normes de construction fixent un débit minimal, en général on estime que la moitié de l'air d'une pièce doit être renouvelé par heure. S'il n'y a pas de circulation d'air spontanée, il faut avoir recours à une ventilation mécanique contrôlée (VMC) ou une ventilation mécanique des bâtiments par insufflation (VMI).

Le principal problème consiste à concilier isolation, économies d'énergie et renouvellement de l'air. En effet, un renouvellement spontané suppose une circulation d'air avec l'extérieur, et donc une fuite de chaleur (l'air chaud sort) ou d'air frais. Sans précaution, l'isolation phonique est également fortement diminuée. (Les sons pénètrent par les ouvertures permettant le passage de l'air).

Il existe des entrées d'air dites « acoustiques » (ECA) permettant de laisser passer l'air tout en arrêtant les sons.

Pour le problème de fuites thermiques, il existe plusieurs solutions :

- Le « puits canadien » (ou « puits provençal ») prélève l'air venant de l'extérieur en le faisant passer dans un long tuyau situé sous terre jouant le rôle d'échangeur thermique passif (la température sous quelques dizaines de centimètres sous terre étant globalement constante, l'air s'y réchauffe en hiver et se rafraîchit en été) ; on perd de l'énergie par l'air sortant, mais on en dépense moins pour mettre l'air entrant à la température visée ;

- La ventilation mécanique à double flux : un échangeur de chaleur permet à l'air entrant de s'approcher de la température de l'air sortant ;

- La surventilation nocturne : dans les entreprises, on utilise un flux d'air modéré durant la journée, et on utilise un flux d'air important la nuit ; il y a trois avantages :

- L'électricité est en général moins chère la nuit ;

- Le bruit de la ventilation ne gêne personne ;

- En hiver, l'arrivée d'air froid ne gêne personne, il a le temps d'être réchauffé le matin à l'arrivée des employés ; en été, on prélève l'air au moment où il est le plus frais.

On peut aussi faire varier la ventilation en fonction du taux d'humidité utilisé ou du taux de CO2, le confort à une température donnée dépendant beaucoup du taux d'humidité et du CO2. On sait qu'un fort taux de CO2 diminue la vigilance et le rendement du personnel jusqu'à 15 %.

Problèmes en cas d'incendie et d'accident industriel

Le feu est alimenté par l'oxygène de l'air. Dans un bâtiment où l'air circule facilement (maison mal isolée, entrepôt), le feu se développe relativement rapidement. Si par contre l'air circule mal, le feu se développe plus lentement, mais on risque un accident thermique lors de l'ouverture d'une porte ou d'une fenêtre (pour la fuite des occupants et l'intervention des pompiers).

Une des principales préoccupations des pompiers est donc la maîtrise de l'air, et notamment :

- Fermer au maximum les ouvertures pour éviter les entrées d'air et la propagation de la fumée qui, elle, doit être évacuée ;

- Couper les VMC et les systèmes de climatisation, qui, outre l'apport d'air, provoquent un mélange des gaz et de l'air et une homogénéisation de la température (naturellement, l'atmosphère se stratifie, les gaz chauds et toxiques se trouvent en haut, l'air froid et respirable en bas) ;

- Certaines procédures opérationnelles prévoient une ventilation opérationnelle destinée à chasser la fumée, pour faciliter les opérations d'évacuation et d'extinction, mais cette technique est difficile à maîtriser.

Par ailleurs, certains accidents industriels peuvent provoquer des émanations de gaz toxiques (fuite, explosion, accident de la route ou catastrophe ferroviaire impliquant un camion- ou un wagon-citerne). Dans ces cas-là, l'unique mesure de protection des populations est le confinement, ce qui implique de limiter au maximum le renouvellement de l'air : couper les VMC et climatisations, fermer toutes les ouvertures (portes, fenêtres, trappes), boucher les aérations et les fuites (dessous de porte), et couper toutes les flammes (chauffe-eau, cuisinière). Ceci devrait être une conduite réflexe en cas d'alerte aux populations, avant même de connaître l'origine du problème, sauf cas particulier (par exemple, alerte spéciale pour les zones en aval des barrages ou pour les zones côtières menacées de tsunami).

Cas particuliers

Aération des habitacles d'automobiles

Le problème de renouvellement de l'air se pose aussi pour les automobiles. En effet, le véhicule est dans le flux de la circulation exposé à la pollution des véhicules le précédant, et les matières plastiques sont de plus en plus utilisées par les constructeurs (avec une odeur caractéristiques de « neuf », incluant des polluants organiques volatils, en particulier lorsque la voiture chauffe au soleil. Par ailleurs, les entrées d'air se situent en général sur le capot, à la base du pare-brise. Elles permettent à un air très pollué par les gaz d'échappement des véhicules précédents de pénétrer dans l'habitacle, en particulier dans les tunnels, voies en tranchées et rues très achalandées et peu aérées.

Une enquête menée par l’Association Santé Environnement France a mesuré la qualité de l’air à l’intérieur des voitures dans 3 villes françaises : Paris, Marseille, Grenoble. L’enquête a retrouvé à l’intérieur des voitures des taux important d’oxydes d’azote et de particules fines 6.

Une étude7 récente a montré que la pollution de l'air mesurée en bord de route ne reflète pas ce qui est respiré à l’intérieur des habitacles (de plus pour éviter les dégradations les capteurs sont parfois placés à plus de 2 m de hauteur et en recul par rapport aux grands axes). L'étude a mesuré la pollution intérieure de l’habitacle d’un véhicule équipé d’appareils de mesure en continu des polluants de l’air intérieur (particules, NO, NO2, SO2, ozone, etc.). Au fur et à mesure, l’environnement du véhicule et son trajet et sa vitesse étaient mesurés avec l’aide notamment d’un GPS et d’une caméra fixée à l’avant. La première partie de l'étude a porté sur 2 parcours différents : 72 km en agglomération rouennaise et 400 km en agglomération parisienne (soit 5 000 km au total)[pas clair]. À titre de comparaison, la pollution de proximité a aussi été mesurée (en bordure de route) et la pollution de fond (en ville) enregistrée à Rouen.

Résultats :

- Les filtres classiques d’habitacles sont peu performants : ils laissent passer la grande majorité des particules émises par les moteurs Diesel (et on n’a pas ici mesuré les nanoparticules) ;

- NO2 : 200 µg/m3 en moyenne dans l’habitacle, soit 10 fois plus que la pollution de fond (22 µg/m3 à Rouen), et plus de deux fois la pollution de proximité (75 µg/m3 à proximité de la route) ;

- Particules : jusqu'à 40 fois plus dans l’habitacle que ce qui est mesuré dans la pollution de fond ;

- Fumées noires (suspectées d'être cancérigènes et impliquées dans de nombreux problèmes de santé, asthme, allergies...) ; une heure passée dans l'habitacle en circulant, équivaut à 24 heures de fond urbain hors véhicule.

- Les concentrations dans l’habitacle varient peu entre Paris et Rouen, sont plutôt homogènes sur la totalité du parcours hormis deux cas de figures :

- les tunnels (400 µg/m3 pour le NO2 en moyenne, et la moitié de la dose qui imposerait de fermer un site industriel, pour la partie terminale du tunnel de la Défense),

- rouler dans le sillage d’un bus ou d’un camion (ex. : 6 min dans le sillage d’un bus équivaut à 8 heures de fond urbain…)

- Passer plus d’1 h/jour en voiture dans le flux de circulation, revient à dépasser très largement le seuil d’alerte de la population (200 µg/m3 de NO2 au maximum 18 h/an).

- Les taux de polluants de l’habitacle varient selon la proximité et les caractéristiques des véhicules suivis, plus que selon la densité du trafic.

- La position du pot d’échappement a une importance : ceux des camions orientés vers la route augmentent fortement la pollution au ras du sol en Europe, alors qu'aux États-Unis, le pot dirigé vers le haut pollue moins les basses couches, mais contribue alors à une pollution plus largement dispersée.

L'auteur recommande de ne pas activer la ventilation dans un tunnel ou quand on sent l'odeur des échappements dans l’habitacle, si possible avant d'être dans cette situation et conclut que les études épidémiologiques d’exposition aux polluants automobiles devraient maintenant aussi tenir compte du temps passé en voiture.

Les concentrations de particules de 300 µg/m3 et des concentrations de NO2 de 2 000 µg suffisent à provoquer une ischémie myocardique à l’effort (ou « angine de poitrine ») chez les insuffisants cardiaque8, or ces taux sont susceptibles d'être atteints dans un habitacle de voiture. Des aménagements de voirie peuvent favoriser la dispersion des polluants pour éviter l’effet « canyon » (en sachant que c’est aussi disperser la pollution plus loin) et exposer un plus grand nombre de gens à de faibles doses.

Cas des habitacles de tracteurs

Les conducteurs de tracteurs et engins agricoles sont exposés à des poussières quand il fait chaud et sec, à des germes (virus, bactéries, champignons lors des épandages de lisiers et fumiers) et parfois à leur propre fumée de diesel ou à celle d'un autre engin agricole, et aussi à des pesticides (lors des épandages) ou résidus ou métabolites de pesticides toxiques. Les tracteurs modernes sont pour cette raison équipés d'une climatisation avec filtration de l'air plus ou moins efficace (il faut un filtre à charbon activé régulièrement changé pour épurer l'air des pesticides qu'il véhicule).

Précision scientifique du langage

L'ADEME considère que l'argument « plantes dépolluantes » n'est pas validé scientifiquement au regard des niveaux de pollution généralement rencontrés dans les habitations et des nouvelles connaissances scientifiques dans le domaine9.

Notes et références

- Les conseils de vos médecins pour votre air intérieur [archive] « Copie archivée » (version du 22 décembre 2015 sur l'Internet Archive)

- Exposé des priorités et programmes de l'Université [archive] (voir page 3/8)

- Trop de polluants dans l'air des crèches [archive] Lci.tf1.fr, 26 mars 2009

- actu-environnement/com [archive] Résultats présentés le 16 juin 2008 par Séverine Kirchner de l’OQAI (Observatoire de la qualité de l'air), à partir de chiffres venant d’une étude nationale sur la qualité de l’air des logements français.

- État de la qualité de l’air dans les logements français – Rapport final [archive] OQAI mai 2007

- «Voitures toxiques : l'enquêteF» [archive], sur Asef,

- Étude sur l’évaluation de l'exposition à des polluants aériens dans les habitacles de véhicules insérés dans le trafic (effets à bas niveau et à long terme) pilotée par Jean-Paul Morin (Unité INSERM 644, Rouen). L'étude complète sera présentée les 09 et 10 juin 2008 au colloque de l’ARET (Association pour la Recherche en Toxicologie) soutenu par l’AFSSET (sur le thème « Exposition aux faibles doses : un défi pour l'évaluation et la gestion des risques pour l'Homme et 'environnement »). La revue de médecine le Concours Médical du 24/01/2008 a rapporté les 1ers résultats de cette étude qui confirme que la concentration de l'air en polluants d'origine automobile est nettement plus importante dans l’habitacle que hors de celui-ci.

- Étude de 2007 publiée par le New England Journal of Medicine.

- « Plantes et épuration de l'air intérieur – ADEME » [archive], sur ADEME (consulté le ).

Annexes

Articles connexes

Liens externes

- (en) Voir les normes de l'American Society of Heating, Refrigerating and Air-Conditioning Engineers (ASHRAE)

Gouttière (architecture)

Une gouttière est un ouvrage de collecte des eaux pluviales disposé à l'égout d'un toit. Elle diffère d'un chéneau par la nature discontinue de son support. Le chéneau est posé sur une fonçure faite généralement de voliges ou de frises jointives, quelquefois de plâtre. La gouttière est portée par des crochets dont les profils caractérisent des façons régionales.

La gouttière est dite pendante quand les crochets sont fixés à l'extrémité des chevrons en saillie, soit directement, soit par l'intermédiaire d'un bandeau d'égout. Elle est dite rampante si les crochets sont fixés à la face supérieure des chevrons ou au voligeage de l'égout. On la pose aussi sur entablement à la façon anglaise, ou sur des crochets munis d'une chevillette fichée dans le mur gouttereau, à la façon du Nord.

On utilise pour façonner les gouttières divers métaux laminés assez rigides pour franchir sans risque de fluage la distance entre les chevrons : le zinc, le cuivre, le fer galvanisé, l'acier inoxydable et l'aluminium, et aussi le PVC.

Elles sont composées d'éléments de longueur standardisée, emboîtés et soudés (ou collés). Elles peuvent aussi être roulées ou profilées en pleine longueur d'usage sur le chantier. Les talons ferment les extrémités. Le fond est ouvert en bas de pente par une naissance ou moignon qui déverse l'eau dans la descente directement, par une volée de coudes ou par une cuvette.

Historique

La nécessité d'éloigner le ruissèlement du toit des fondations de l'édifice s'est avérée dès que l'homme sédentaire a voulu assurer la pérennité de son installation et la conservation de ses victuailles. On a eu recours, tout d'abord, à une large saillie de l'égout à l'aplomb duquel on aménageait un caniveau destiné à évacuer l'eau dans la pente du terrain ou vers un cours d'eau naturel. Cet usage garda sa pertinence autant que l'habitat resta peu groupé.

La densité d'occupation des cités, surtout quand elles se renfermèrent dans des murs, imposa un contrôle plus rigoureux de la destination des eaux pluviales. On en vint à concevoir une collecte par réseaux publics, intégrés à la voirie et composés de caniveaux de rue et d'égouts souterrains. L'adduction privée y aboutissait par des gargouilles au bas de la pente de chéneaux de pierre parfois revêtue de plomb, lesquels chéneaux couraient sur les murs gouttereaux1.

Viollet-le-Duc mentionne, dans son Dictionnaire raisonné, des tuiles gouttières utilisées depuis le XIIe siècle sur l'habitat bourgeois. Ce sont de longues tuiles de courant souvent vernissées et dont une rive est rabattue et prolongée en méplat pour former une queue qu'on scelle entre l'entablement et le rang de doublis2. L'usage en est encore vivant dans le Roussillon et en Catalogne.

En 1845 M. Toussaint de Sens définit la gouttière dans le vocabulaire qu'il annexe à son manuel d'architecture, puis il ajoute qu'« on en fait aussi en bois de chêne recreusé. »3 Augustin Magné et Henri Somme signalent encore en 1947 des gouttières en bois: « …on en voit encore dans les campagnes composées simplement de deux planches clouées d'équerre et aboutissant à une descente formée d'une simple corde tendue par le poids d'une pierre qui conduit, tant bien que mal, l'eau dans un tonneau. »4

Avant le XIXe siècle, dans les Alpes où le bois abonde, on creusait des demi-futs de résineux minces qu'on fixait à l'aide de chevilles sous l'égout des toits de bardeaux. C'est une façon que l'on peut encore observer au début du XXIe siècle dans certaines vallées de Savoie5, et dans d'autres pays où l'on construit en bois.

À Ouessant, où l'eau douce est rare, une ruellée de mortier biaise disposée à l'égout, dirige le ruissellement vers une citerne. On trouve aussi en pays Bigouden des ruellées rampantes en forme d'accent circonflexe au-dessus de la porte, pour protéger le seuil du rideau de pluie6.

Les premières vraies gouttières étaient en cuivre et permettaient au mur gouttereau de devenir la façade du bâtiment. Pourtant, ce n'est que dans la deuxième moitié du XIXe siècle, avec l'essor de l'industrie du zinc laminé, que l'usage des gouttières se répandit dans les centres urbains. Les travaux haussmanniens favorisèrent l'élaboration et la diffusion de cette nouvelle technique qui se généralisa bientôt.

Les parties de la gouttière

La gouttière forme une rigole dont le fond est en pente, chacune de ses extrémités est fermée par un talon rapporté et soudé ou emboité. Le fond du bas de pente est ouvert par une naissance cylindrique ou conique dont le collet battu est soudé, et qui dirige le ruissellement vers un tuyau de descente ou vers un « jet de volée », d'où l'eau tombe directement au sol.

Elle est fabriquée industriellement en éléments de deux, quatre ou six mètres par profilage de bandes de métal, ou façonnée par le zingueur en atelier ou sur le chantier. La rive extérieure est ourlée d'un « boudin » pour améliorer la rigidité et l'aspect, la rive intérieure ou dosseret a le bord franc ou muni d'une pince7 assez ouverte.

Les éléments peuvent être emboités à recouvrement, quelquefois rivetés, et collés ou soudés jusqu'à atteindre une longueur totale de dix à douze mètres pour le zinc et le PVC, et davantage pour l'aluminium, le cuivre et l'acier. La nécessité de ménager un jeu pour la dilatation interdit de dépasser des longueurs définies par les normes (en France, le DTU 40-41 pour le zinc). Au-delà de ces longueurs, on doit diviser la gouttière par un joint de dilatation. Les joints de dilatation sont de plusieurs sortes :

- les joints à besace dont les éléments sont emboités mais non soudés, chacun a son talon et les talons sont couverts d'une pièce de zinguerie: la besace qui protège du ruissèlement le pertuis qu'on laisse entre eux et rejette l'eau de part et d'autre, dans les gouttières qu'on aboute ;

- les joints de néoprène qui sont posés au fond d'une jonction non soudée et soudés à chacun des éléments qu'ils joignent ;

- les joints coulissants de PVC, sans collage.

Les joints à besace ont l'inconvénient de diviser la pente et d'ajouter des descentes.

Les éléments peuvent aussi être joints en retour d'angle lorsque la ligne d'égout est brisée par un arêtier ou par une noue. Les deux bouts à joindre sont coupés d'onglet et l'on façonne un bord, par étirage et rétreint, au côté qui recouvre, puis l'on soude. Des retours d'équerre sont emboutis en usine.

Les types de gouttières

La gouttière peut être suspendue sous un égout saillant ou posée sur un entablement par l'intermédiaire de crochets qui déterminent la pente. C'est alors une gouttière pendante, dont le dosseret est dans un plan vertical donc sécant au plan du rampant. Les gouttières pendantes ont souvent le profil demi-circulaire, on les appelle « demi-ronde ». Il y en a une variante, la gouttière lyonnaise, qui a l'ourlet plus gros. On en fait d'autres dont le profil est rectangulaire et certaines dont la face est ornée de moulures parfois même estampées de guirlandes florales. Sur entablement, on pose la gouttière anglaise, demi-ronde à gros ourlet, dont le développement latéral est inconstant pour que l'ourlet reste de niveau.

Certaines gouttières sont posées sur le bas du rampant, leur dosseret est dans le plan du rampant, ce sont les gouttières rampantes. Il en existe quelques variantes régionales dont l'ourlet se relève par une courbure tangente ou par un pli. Un pli de cent dix degrés fait un relevé de huit ou dix centimètres à la gouttière nantaise, dite aussi gouttière Laval. La gouttière ardennaise, dite aussi gouttière havraise, est roulée selon un rayon de cinq centimètres environ sur cent quarante degrés.

Chaque type régional peut être façonné en plusieurs dimensions selon le débit d'eau qu'on attend qu'il aura. La dimension, définie par la largeur développée en centimètre, est de dix-sept, vingt-cinq, trente-trois ou quarante : les divisions entières par douze, huit, six et cinq de la feuille de deux mètres qu'on fabriquait exclusivement au XIXe siècle. Les gouttières rampantes peuvent aussi être façonnées à développement variable; on règle alors le dosseret de niveau pour éviter le tranchis d'égout biais.

Les matériaux utilisés

Les gouttières, surtout en milieu urbain, sont façonnées le plus souvent dans des feuilles de métal laminé (acier galvanisé adapté au climat montagnard, acier inoxydable, aluminium brut ou laqué, cuivre ou zinc). On les monte aussi à partir d'éléments moulés en PVC (moins chers et plus légers, résistants à la corrosion mais au moins bon vieillissement) ou en fibrociment. Certaines façons traditionnelles étroitement localisées font usage de bois ou de terre cuite.

Les gouttières en aluminium, sont elles profilées en continu sur le site de pose. Les parties droites sont sauf très grandes longueurs en une seule pièce, en cas de raccord « en angle » des pièces d'adaptation permettent une jonction par rivetage et jointoiement en silicone. Ce matériau est en outre revêtu d'une laque « époxy » dans une gamme de couleur contribuant à une meilleure esthétique des constructions8.

La pose

Le débit d'une gouttière dépend de sa pente, de la surface, et de la forme de la section de son écoulement. On admet que la pente ne doit pas être inférieure à cinq millimètres par mètre, mais la dénivellation des extrémités d'une gouttière de douze mètres atteint six centimètres qui ne peuvent guère être dépassés sans désordres techniques et esthétiques. Aussi s'en tient-on souvent à cette pente raisonnable.

La section d'écoulement doit être considérée la gouttière étant en place, avec le dosseret plus haut que l'ourlet de dix millimètres au moins, pour tourner à l'extérieur d'éventuels débordements. Sa surface est en proportion du carré de la largeur développée de la gouttière. Le DTU 60.11 donne un tableau qui permet d'évaluer la section minimale nécessaire à desservir une toiture mesurée en plan. Les sections minimales requises de formes rectangulaires et triangulaires doivent être majorées respectivement de dix et de vingt pour cent. Ainsi une gouttière demi-ronde pendante de vingt-cinq permet de traiter l'égout d'un pan de couverture (ou d'un ensemble de pans) dont la surface en plan égale trente-sept mètres carrés, tandis que celle de trente-trois traite une surface en plan de quatre-vingt-cinq mètres carrés9.

Précautions

Les gouttières obstruées provoquent une accumulation d’eau, ce qui peut occasionner des infiltrations dans la maison. Ayant du mal à s’écouler, cette eau stagnante favorise la prolifération des moustiques et des mauvaises herbes dans les gouttières.

Pour prévenir l’obstruction des gouttières, il est important de nettoyer régulièrement les feuilles et autres débris qui s’y accumulent. Les gouttières bouchées peuvent déborder et miner les fondations, endommager la charpente de toit et favoriser la formation de blocs de glace par temps froid.

Protège-gouttières

Le protège-gouttières aide la gouttière à remplir son rôle, qui est de capter l’eau qui ruisselle sur le toit et de l’éloigner des façades et des fondations de la maison. Il empêche ainsi les feuilles, les déchets végétaux, la poussière, les aiguilles et la mousse de s’y accumuler, réduisant du coup les risques d’obstruction de la gouttière ou de la descente et l’entretien nécessaire pour les garder propres. Le protège-gouttière permet également de garder la neige et la glace hors des gouttières, favorisant ainsi un bon écoulement de l’eau toute l’année. Enfin, il sert de barrière contre la vermine pour éviter que les petits animaux, les oiseaux et les insectes n’entrent dans la gouttière.

Types de protège-gouttières

On trouve plusieurs sortes de dispositifs de protection de gouttières sur le marché : des protège-gouttières encliquetables en métal et en plastique, des modèles en acier inoxydable, à filtres et à charnières, des crépines, des couvre-gouttières en métal et en plastique et même des brosses qui ressemblent à d’énormes chenilles velues.

Certains protège-gouttières sont composés d’un filet ou d’un treillis, en rouleau ou en morceaux, qu’on installe sur les gouttières. Généralement, ce filet est en métal, mais il en existe également des modèles en plastique. On retrouve également des plaques d’aluminium ou de PVC perforées de différentes épaisseurs qui se fixent ou se vissent sur le dessus de la gouttière. Il y a aussi des modèles composés de brosses de métal ou de morceaux de mousse qui remplissent complètement la gouttière pour filtrer les débris. Enfin, certains modèles sont fabriqués en cuivre pour protéger les gouttières de cuivre qui réagissent aux autres métaux.

Indépendamment du modèle choisi, tous les systèmes de protection de gouttières doivent être inspectés deux fois par année aux fins de nettoyage et de réparation.

Inconvénients

Les protèges gouttières, en fonction des types de végétaux situés dans l'environnement des constructions ne sont pas forcément la solution parfaite : feuilles plates se collant à plat sur les grilles, aiguilles de résineux se "plantant" dans les protèges gouttières, etc. Une autre solution consiste donc en la mise en place de crapaudines aux jonctions des gouttières et des descentes.

Notes et références

- Cet article est partiellement ou en totalité issu de l'article intitulé « Protège-gouttières » (voir la liste des auteurs).

- Cf Georges Doyon et Robert Hubrecht, L'Architecture rurale et bourgeoise en France, éditions Vincent, Fréal et Cie, Paris (1969), (ISBN 978-2707200785), (p. 460 à 464).

- Cf l'article « Tuile » du Dictionnaire raisonné de l’architecture française du XIe au XVIe siècle sur Wikisource [archive].

- Cf M. Toussaint de Sens, Nouveau manuel complet d'architecture ou traité de l'art de bâtir, Librairie Encyclopédique Roret, 1845. [archive]

- Cf A. Magné et H. Somme, Traité pratique de couverture : Ardoise, tuile, zinc, plomb, cuivre et autres matériaux, éditions Garnier frères, Paris, 1947, (p. 247).

- Cf Marie-Thérèse Hermann, Architecture et vie traditionnelle en Savoie, La fontaine de Siloé, (ISBN 2-84206-122-5), (p. 177).

- Cf Patrick Hervé, Maisons paysannes en Bretagne,Skol vreizh,1991, (ISBN 2 903313 42 3), (p. 45).

- En zinguerie, une pince est un bord plié à plus de 135 degrés. La pince donne de la tenue à la rive, permet l'agrafure de pattes ou de la pince d'agrafage inversée d'une autre pièce et s'oppose à la remontée de l'eau par dépression.

- Site Dal'alu [archive]

- Cf Le mémento du couvreur zingueur, Vmzinc, 2010, page 52.

Voir aussi

Bibliographie

- Mémento du couvreur zingueur, édité par le Centre du Zinc (13e éd. 1989)

- Le mémento du couvreur zingueur, VMZINC, édition 2013

- Robert Longechal, Toitures et gouttières, Paris, Rustica, 1996, 80 p.

Articles connexes

- Architecture

- Toit

- Égout (architecture)

- Techniques alternatives pour la gestion des eaux de ruissellement urbain

- Chaîne de pluie

- Gargouilles de la cathédrale Notre-Dame de Paris

Ventilation

La ventilation est l'action qui consiste à créer un renouvellement de l'air, par déplacement dans un lieu clos. Elle est mise en œuvre dans les lieux où l'oxygène risque de manquer, ou bien où des polluants et autres substances indésirables (humidité, par exemple) risqueraient de s'accumuler en son absence : logements, bureaux, magasins, salles de spectacles, d'enseignement, ouvrages souterrains, tunnel routier, atelier industriel, mine…

L'AFSSET a en France constaté que « le fonctionnement constaté de ces dispositifs ne correspond pas toujours au fonctionnement théorique et que le cheminement de l’air dans les bâtiments n’est pas toujours conforme aux prévisions »1.

Histoire

Avant le XIXe siècle

L'éventail, inventé par les Chinois et autres Pankas (ou Punkha), faisant partie des appareils de ventilation2 les plus élémentaires et les plus anciens, permettent de ménager un courant d'air rafraîchissant, dans les ambiances surchauffées des régions orientales3. Dans le même esprit les Badgirs ou « tour à vent » réalisent par tirage, une ventilation naturelle dans les édifices persans depuis des siècles et associée à une Yakhchal, permettent même la conservation de la glace dans des conditions de chaleur extrême en Iran, ainsi les ingenieurs persans de l'époque réalisent une des premières climatisation.

L'appareil de ventilation le plus commun et le plus primitif est toutefois probablement la cheminée, ou le trou ménagés au-dessus d'un foyer dans toutes les constructions du monde; L'air chaud est éventuellement aspiré dans un tuyau de cheminée, la force chargée de mettre en mouvement la colonne d'air est assurée par la chaleur du foyer, l'arrivée d'air se fait par les fissures et imperfections des parois de la construction.

Dans la Rome antique et jusqu'au Moyen Âge, les fenêtres étaient juste pourvues de volets, que l'on devait ouvrir pour faire entrer la lumière4. On ne parlait pas de ventilation mais la circulation d'air à l'intérieur du bâtiment était libre et abondante, assurées par les jeux de pression qui existent hors et dans le bâtiment.

Surtout dans le Nord, la nécessité de se protéger du froid et de retenir la chaleur des foyers, oblige à substituer aux panneaux de bois des volets, des éléments translucides, dans le meilleur cas du verre, transformations successives qui aboutissent au châssis de fenêtre moderne, qu'il n'est pas nécessaire de laisser ouvert pour faire entrer la lumière. D'une manière générale, par une amélioration des fermetures de baie, des matériaux et de leur mise en œuvre, le bâtiment va vers une plus grande étanchéité à l'air. On voit dès lors, la ventilation associée au chauffage, l'un étant antinomique de l'autre.

Lorsqu'elle s'érige en science milieu XVIIIe siècle, la ventilation s'intéresse à des milieux confinés dont font désormais partie les bâtiments3.

Mais la science s'est d'abord attachée à des lieux comme les mines, puis les intérieurs de navires, ensuite les prisons, les casernes et enfin les hôpitaux « où des masses de chair humaine en décomposition plus ou moins avancée empoisonnent l'atmosphère3».

La première ventilation artificielle dont l'histoire fasse mention est celle que conseille Hippocrate en –4605, lors d'une épidémie à Athènes et celle qu'on appliqua encore au XIXe siècle quelques villes du Midi de la France pendant la quatrième pandémie de choléra, à savoir l'allumage de vastes foyers sur les places publiques. Ces foyers brûlaient une partie des miasmes aériens et provoquaient un courant d'air dans l'atmosphère ambiante, mais ils exigeaient une masse énorme de combustible et n'agissaient que sur des surfaces très restreintes3.

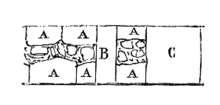

La figure 124 tirée de son ouvrage indique presque tous les progrès réalisés au XIXe siècle. Il conseille :

- Un foyer extérieur pour l'introduction de l'air pur préalablement chauffé en hiver ;

- La pente à donner au plafond pour faciliter la sortie de l'air vicié par un tuyau central ;

- Des gaines séparées pour chaque étage ;

- Un foyer d'appel placé dans les combles où il indique clairement tous les moyens usités au XIXe siècle y compris la prise d'air sur les toits quand on a à craindre les émanations du sol.

Léopold Genneté. Principe de ventilation des hôpitaux, 1767.

Un ouvrage de 1557, que Georgius Agricola publie à Bâle sur l'exploitation des mines, le De re metallica6, indique les moyens employés alors pour la ventilation et on reconnaît dans le dessin de l'époque les mêmes moyens artificiels encore employés au XIXe siècle: Le soufflet, le ventilateur rotatif, le ventilateur à ailes et à quadruple compartiments. Il est déjà question de divisions pour les courants montants et descendants3.

En 1745, Samuel Sutton s'occupe spécialement de la ventilation des navires7.

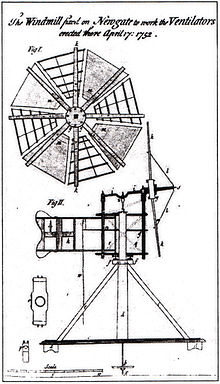

À partir de 1734, John Theophilus Desaguliers3, et le physiologiste, chimiste et inventeur britannique Stephen Hales, introduisent les ventilateurs mécaniques pour aérer la prison de Newgate, les hôpitaux et surtout les Chambres des communes où une « roue centrifuge » est employéen 1. En 1750, un comité est institué à Londres, par la Royal Society, pour examiner le mauvais état de ventilation de ces prisons qui produit alors « la maladie bien connue sous le nom de fièvre des prisons ». Sir John Pringle auteur de Observations on the Nature and Cure of Hospital and Jayl Fevers et le docteur Hales recommandent l'usage d'un ventilateur inventé par ce dernier et bientôt les décès à Newgate sont réduits de sept ou huit par semaine, à environ deux par mois. On a une idée de ce qu'est alors la prison de Newgate, par ce fait que des onze ouvriers employés à établir le ventilateur, sept sont attaqués de la fièvre et un en meurt8.

Devant la presque disparition de mort par la « fièvre des prisons », l'usage des ventilateurs inventés par Stephen Hales, se généralise dans ces établissements, ainsi que dans les hospices et les navires. Leur emploi se répand également en France, où Hales obtiendrait du roi Louis XV, à l'occasion d'une guerre avec la France, l'autorisation de faire installer de tels dispositifs dans les dépôts où sont retenus des prisonniers anglais.

En France, Duhamel du Monceau est le premier qui en 1759 indique dans son ouvrage l'emploi de l'appel fourni par les fourneaux de cuisine des navires pour désinfecter les cales3. Il s'inspire des travaux de Hales dans l'établissement de la ventilation des greniers à blé.

En 1767, Léopold Genneté faisant ressortir les inconvénients des moteurs mécaniques de ses devanciers, expose l'application aux hôpitaux de la ventilation par appel d'air qu'il a observée à Liège dans les mines où on la pratique depuis des siècles3.

Apports du XIXe siècle

La chimie connaît un énorme progrès quantitatif avec Antoine Lavoisier qui l'a promue en science exacte. Les bases de la théorie de la chaleur sont posées, on étudie la propagation de la chaleur à travers les corps, les lois du réchauffement et du refroidissement9, les phases gazeuses, etc.

Début XIXe siècle, les questions de ventilation, de chauffage et d'assainissement en général, deviennent une préoccupation majeure, sous l'impulsion des courants hygiénistes, d'abord en Angleterre (prison de Pentonville, Guy's Hospital, etc.), plus tard en France. Il est question de la ventilation dans les habitations particulières, dans les casernes et les hôpitaux. En France, Jean-Pierre-Joseph d'Arcet est le premier qui au commencement du siècle applique la science d'une manière pratique et sérieuse à la salubrité des ateliers et des théâtres3. « En hygiène publique l'air est à là fois comme l'eau un aliment et un agent de désinfection ou de purification ». Le renouvellement de l'air peut être obtenu de diverses manières et est principalement indispensable là où se trouvent réunis beaucoup d'individus donnant lieu à de la chaleur et à des miasmes soit par eux-mêmes soit par les matières qu'ils travaillent ou par suite de leurs maladies hôpitaux ou dans des lieux destinés à recevoir les immondices ou les matières excrémentielles. L'hygiène publique se préoccupe de l'« aération extérieure », celle qui résulte de la disposition des cours de tous les édifices et maisons, de la largeur des rues, de leur direction, de leur exposition au midi, etc. « Faire de larges rues, des maisons peu élevées, des places spacieuses, des cours d'habitation proportionnées à la surface des bâtiments, […] tels sont les grands moyens de ventilation publique d'une ville que toute bonne administration doit chercher à établir malgré les oppositions et le mauvais vouloir de certains intérêts privés10 ».

Les principes de la ventilation sont alors toujours assez simples. Pour ventiler une pièce il faut trois choses une entrée, une sortie, une force. Toute capacité close où l'on voudra produire un renouvellement de l'air doit être munie d'au moins deux orifices, un orifice d'entrée et un orifice de sortie, l'un placé en haut autant que possible, l'autre dans le bas et loin du premier.

L'orifice de sortie est mis en communication avec une colonne d'ascension soumise à une force calorifique quelconque ou à un ventilateur mécanique et cette force combinée avec la grandeur des orifices et la hauteur de la colonne détermine la mesure de la ventilation obtenue.

L'appareil de ventilation par excellence celui qui est le plus commun, est alors et toujours la cheminée d'appartement; la colonne d'ascension c'est le tuyau de cheminée, la force c'est le foyer, l'arrivée ce sont souvent les fissures des portes et des fenêtres quand il n y a pas de ventouses suffisantes et de prise d'air derrière le foyer. Un foyer ordinaire d'appartement peut déterminer par son tirage une évacuation de 800 à 1 000 m3 d'air par heure et malheureusement c'est là le rôle principal des cheminées. En effet cette évacuation d'air à l'extérieur et par conséquent le refroidissement des pièces sont d'autant plus considérables que le chauffage fonctionne avec plus d'activité. Rarement les prises d'air extérieur qu'on a ajoutées dans des systèmes de tuyaux plus ou moins contournés sont suffisantes pour alimenter la combustion et pour remplacer l'air ascendant du tuyau de fumée. Ce sont toujours les portes et les fenêtres qui viennent donner le complément d air indispensable3.

Dans les grands espaces, des ventilateurs mécaniques sont actionnés par des machines à vapeur qui nécessitent éventuellement, l'assistance d'un machiniste!

Dès 1800, le gaz d'éclairage arrive dans les appartements. Encore au début du XXe siècle, causés par le gaz de houille le gaz principalement utilisé, des utilisateurs se plaignent de mauvaises odeurs, de céphalées et de vomissements. Le gaz de houille, issu d'une pyrolyse de la houille est un mélange empoisonné de monoxyde de carbone, de sulfure d'hydrogène (et de méthane et d'hydrogène qui eux ne sont pas toxiques) qui oblige à une épuration physique et chimique qui sera longtemps imparfaite11. La combustion du gaz de houille d'une part emprunte à l'air ambiant l'oxygène dont elle a besoin, et d'autre part rejette dans celui-ci le dioxyde de carbone, le dioxyde de soufre et lorsque la combustion est incomplète ou lorsqu'il y a des fuites, le très dangereux monoxyde de carbone, autant de produits toxiques ou corrosifs qui obligent dès lors à ventiler. L'emploi des ventilateurs et ventouses, fait désormais loi dans les appartements12.

Le gaz d'huile et surtout la lumière oxhydrique sont envisagés comme solutions alternatives car moins polluants. À partir de 1880, l'électricité en remplaçant le gaz dans ses applications d'éclairage, signifie une amélioration substantielle de la qualité de l'air intérieur.

Les progrès réalisés dans les machines à vapeur profite aux installations de chauffage domestiques. Les calorifères, un des premiers système de chauffage central, réalisent une petite révolution en délocalisant une chaudière unique, source de pollutions diverses, et permettent de mieux contrôler le chauffage et la ventilation des pièces d'habitation. Des fluides caloporteurs sont mis en œuvre, acheminés dans des tuyaux vers des radiateurs, chargés de disperser la chaleur dans les pièces13.

Apports du XXe siècle

La climatisation moderne est inventée par Willis H. Carrier en 1902.

Le chauffage, ventilation et climatisation, sont de plus en plus souvent associés. Aux États-Unis, on les retrouve dans une discipline unique appelée « HVAC » (pour Heating, Ventilation and Air-Conditioning). L'HVAC devient une entreprise mondiale dont le rôle consiste en l'exploitation, la maintenance, la conception et la construction de systèmes, la fabrication et la vente d'équipements, l'éducation et la recherche. Cette industrie est historiquement régulée par les fabricants d'équipements HVAC, mais des organismes de régulation et de standardisation comme l'American Society of Heating, Refrigerating and Air-Conditioning Engineers (ASHRAE) sont instaurés dès 1894 pour soutenir l'industrie et encourager des standards élevés de finition.

Le premier choc pétrolier en 1973 aboutit dans les climats froids et tempérés, et surtout dans les pays occidentaux, à un nouveau type de construction faisant un usage intensif de l'isolation thermique. La pose de l'isolation s'accompagne de membranes plus ou moins étanches, de pare- et de freines-vapeurs qui visent à protéger l'isolant de toute atteinte par l'humidité ambiante ou extérieure. Les bâtiments de fait deviennent de plus en plus étanches, et la ventilation, qui est naturelle ou forcée, se préoccupe désormais d'évacuer le surplus d'humidité intérieur et surtout d'assurer le renouvellement d'air nécessaire à la respiration.

Dans les concepts du type « maison passive », développé à partir d'expériences réalisées dans les années 1970, les bâtiments sont totalement étanches, et la ventilation totalement assurée par des moyens artificiels.

Avec le protocole de Kyoto en 1997, visant à la réduction des émissions de gaz à effet de serre, les États s'arment d'une batterie de règlements visant à améliorer la performance énergétique des bâtiments ainsi que leur dépendance aux sources d'énergies fossiles. La conception des bâtiments prend en considération désormais les caractéristiques thermiques, l'étanchéité à l'air du bâtiment, les équipements de chauffage et d'approvisionnement en eau chaude ; les installations de climatisation, la ventilation, ainsi que dans l'implantation la compacité et l'orientation du bâtiment, les systèmes solaires passifs et les protections solaires, l'éclairage naturel, etc. La paroi devient un objet de haute technicité.

Les matériaux de construction modernes contenant par exemple du formaldéhyde et d'autre part la découverte de nouvelles sources de pollution, telles le radon, deviennent un motif supplémentaire de ventilation.

Utilités

La ventilation d'un lieu a de manière générale plusieurs justifications :

- renouveler l'air ambiant, l'assainir, le dépoussiérer ;

- assurer la climatisation (chauffage ou refroidissement) du local ;

- réguler le taux d'hygrométrie (humidité) ;

- gérer la pression atmosphérique d'un lieu clos (en surpression ou en dépression) ;

- contrôler la concentration du CO2 et des divers polluants intérieurs.

Suivant le lieu où elle est mise en œuvre, l'une de ces justifications est plus spécifiquement poursuivie.

Moyens mis en œuvre

Pour assurer le déplacement de l'air, on peut avoir recours à plusieurs systèmes :

- la convection naturelle, qui consiste à utiliser uniquement les transferts de chaleur et les courants d'air naturel (vents), pour déclencher le déplacement de l'air ;

- la ventilation mécanique est la plus courante, elle est généralement imposée par des normes simples et simplistes, elle reste complexe à maîtriser puisqu'elle se combine nécessairement aux phénomènes convectifs naturels qui varient selon chaque contexte : on utilise un ventilateur, (hélice ou turbine) entraînée par un moteur électrique pour souffler et/ou aspirer l'air.

Type de ventilations

Dans les bâtiments habités, six grands types de ventilations existent :

Ventilation naturelle

Elle se fait par ouvrants extérieurs ou via des conduits à tirage naturel.

Elle se base, passivement, sur trois moteurs naturels que sont le vent, le tirage thermique (l'air chaud monte) et le tirage aéraulique (suscité par la différence de pression entre un point haut et un point bas : la pression atmosphérique plus faible en hauteur induit une dépression faisant spontanément circuler l’air dans le bâtiment). Gratuite et passive, généralement silencieuse, la ventilation naturelle est présente dans la plupart des constructions traditionnelles et immeubles d'habitation (en France dans près des 2/3 du parc de logements soit presque tous les logements construits avant 1975)14 ;

Ventilation hybride

Elle combine les avantages de la ventilation naturelle et de la ventilation mécanique en jouant sur le dimensionnement des gaines de ventilation naturelle, et en utilisant des dispositifs légers (éléments autoréglables, hygroréglables ou statiques) couplés à une assistance mécanique intermittente à basse pression. En générale, une sonde de température, un anémomètre ou un pressostat active automatiquement l'apport mécanique pour compléter l'action des moteurs naturels, uniquement quand c’est nécessaire, en fonction des conditions climatiques et de l'activité des utilisateurs du bâtiment (ex : ventilation accentuée au moment des repas)14.

Il est ainsi permis de valoriser au mieux les forces motrices gratuites et naturelles, en réduisant fortement la consommation électrique des auxiliaires et le bruit de ventilation (qui peut gêner certaines personnes autistes ou hypersensibles) ;

Des entrées d'air hygroréglables font entrer l'air extérieur dans les pièces de vie (chambres, salon, séjour) alors que l'air intérieur vicié est extrait via les pièces techniques (toilettes, salle de bain, cuisine) par des orifices d’extraction, éventuellement hygroréglables donnant sur la gaine de ventilation connectée au ventilateur. Si le système est bien dimensionné, les pressions générées en ventilation hybride sont très faibles, proches de celles de la ventilation naturelle, c'est à dire de 5 à 15 Pa au niveau des grilles (ce pourquoi les conduits adaptés à la ventilation naturelle et hybride sont prévus pour fonctionner à des dépressions de l’ordre d'environ 10 Pa et peuvent être moins étanches que les conduits adaptés à la ventilation mécanique, qui doivent eux supporter des dépressions de 100 Pa et plus)14. Pour le meilleur confort sensoriel, en tenant compte des prospectives climatiques, une attention particulière est à porter à l'humidité, aux phénomènes de condensation, aux calculs de force motrice naturelle disponible, de pertes de charge, de calcul du débit à extraire, du foisonnement et du besoin d'assistance mécanique, avec prise en compte des débits de pointe. Idéalement le système est à concevoir avant la construction. Pour des raisons environnementales et d'évolution de la réglementation évoluant, la gestion hybride de l’air tend à être pilotée par un automate associé à des capteurs intelligents14.

Dans le cadre des lois Grenelle chargées de mettre en oeuvre le Grenelle de l'environnement et des engagements de la France à réduire ses émissions de gaz à effet de serre, elle est encouragée par l'ADEME qui qa publié un guide dédié au sujet, ainsi qu'un cœur de calcul logiciel (« DimVNHy® ») ; outil qui peut être couplé au logiciel SIREN du CSTB pour mieux évaluer la qualité de l'air intérieur des locaux et compléter les Avis Techniques des systèmes hybrides et/ou asservis (hygroréglables)14.

Ventilation mécanique contrôlée simple flux

Elle est plutôt présente dans l'habitat individuel et dans l'habitat collectif récents, ainsi que dans certains bâtiments du secteur tertiaire.

Ventilation électrique contrôlée double flux

Elle est surtout présente dans le bâtiment tertiaire.

Ventilation centralisée

Contrôlée par une ou plusieurs centrale de traitement d'air, avec ou sans recyclage d'air, on la trouve surtout dans les bâtiments tertiaires (hypermarchés, centres commerciaux et immeubles de bureaux, Laboratoires) ;

Ventilation industrielle

Présente dans les usines, elle peut utiliser des débits plus importants, être associé à des processus de détection et gestion des risques et dangers ([ex : HACCP] (cf. gaz inflammables, mélange explosif ou toxique, nanoparticules, microparticules, contaminants biologiques, bactériologiques ou radioactifs, etc. ).

Utilisations

Dans les mines

En milieu de soins

Plusieurs travaux de l'OMS15 recommandent la ventilation naturelle en milieu hospitalier, comme l'une des mesures environnementales efficaces pour réduire le risque de propagation d'infections en milieu de soin. L'OMS spécifie notamment des débits minimums par patient.

La ventilation mécanique contrôlée peut s'avérer dans certaines circonstances plus efficace que la ventilation naturelle mais présenter des noyaux de condensation infectieux dans ses composants, et en définitive constituer un risque accru de transmissions de maladie.

Magasins, bureaux, véhicules, lieux publics

Dans de nombreux, pays, un système de ventilation contrôlé est obligatoire dans tout lieu clos accueillant du public. Une réglementation spécifique pour chaque type de bâtiments et usages définit les moyens à mettre en œuvre.

Généralement un système de renouvellement à aspiration type VMC grande échelle est la base de la ventilation de ces lieux. Elle intègre généralement la climatisation (chauffage et refroidissement).

Pour satisfaire aux prescriptions réglementaires en matière de sécurité, on lui associe, lors de la rénovation ou la construction du bâtiment, un système indépendant de ventilation opérationnelle de grande puissance permettant d'aspirer les fumées d'un d'incendie. Ce système annexe est directement et exclusivement contrôlé par les sapeurs-pompiers lorsqu'ils se rendent sur place.

Laboratoires

Les laboratoires d'analyse et de recherche ainsi que certains sites de fabrication sont munis de systèmes de ventilation spéciaux.

L'air venant de l'extérieur est filtré, chauffé ou refroidi, humidifié ou déshydraté, soufflé et réparti dans les pièces, ensuite il est extrait, filtré ou recyclé avant d'être rejeté à l'extérieur. La pression dans chaque pièce et les diverses consoles est contrôlée (surpression ou dépression).

- Ceci, afin que la santé des chercheurs et des opérateurs ne soit pas compromise par les produits manipulés. Ces produits peuvent être des micro-organismes, des produits chimiques, des matières explosives ou toxiques.

- Les produits de recherche ne doivent pas être contaminés par d'autres produits ou poussières, pas plus que certains gaz ou produits ne doivent pas s'échapper à l'extérieur et contaminer l'environnement.

- Il en est de même pour la fabrication des sondes spatiales, des circuits électroniques et puces d'ordinateur et d'autres produits, qui sont obligatoirement fabriqués dans une salle blanche, c'est-à-dire sans poussière.

Unités de fabrication

Dans les usines, les unités de fabrication mettent en pratique les découvertes des chercheurs. Les ouvriers et opérateurs doivent pouvoir œuvrer sans danger pour leur santé. Les mêmes conditions de ventilation que pour les laboratoires s'appliquent encore, parfois à plus grande échelle.

Tunnels routiers

La ventilation des tunnels routiers pose un problème particulier, notamment en ville : il est nécessaire d'évacuer les gaz d'échappement des moteurs thermiques des véhicules, et la fumée toxique en cas d'accident.

- Pour les tunnels assez courts ou en pente, une ventilation naturelle peut suffire, éventuellement assistée de ventilateurs qui forcent la circulation permanente de l'air.

- Pour les plus grands tunnels, les gaz sont en général aspirés via des cheminées et rejetés à l'air libre au-dessus du niveau du tunnel. Cette méthode peut aboutir à une forte pollution de la zone autour du point de rejet. Ce fait est évidemment néfaste, surtout si elle correspond à une zone fortement urbanisée (exemple : le plateau de la Croix-Rousse à Lyon, situé au-dessus d'un des plus anciens tunnels routiers de France 1952).

À la suite de l'incendie du tunnel du Mont-Blanc, une vaste campagne de mise aux normes de la ventilation des tunnels en France est en cours.

Véhicules automobiles

Utilisations particulières et problèmes liés

- En ville ou en zone industrielle, il est parfois difficile de trouver de l'air propre.

- Dans n'importe quel intérieur mal ventilé, la majorité des polluants sont généralement produits au sein même de l'habitat

- L'entretien des gaines et des éventuels filtres est souvent mal fait ou oublié.

- La ventilation n'est pas toujours correctement dimensionnée, dans les salles de classe notamment, ou alors elle se fait avec des pertes importantes de calories.

- La climatisation qui est de plus en plus souvent associée est une source de pollution et de gaspillage d'énergie.

- La ventilation par gaines peut induire des bruits désagréables voire nuisibles à la santé, si la conception et/ou le montage comportent des lacunes ou des manquements.

- Pour le bon fonctionnement de la Ventilation mécanique contrôlée ou de la Ventilation par insufflation, il convient de veiller à leur état de propreté et à ne pas boucher les entrées ou les sorties d'aération16.

Bibliographie

- Louis Figuier, Les Merveilles de la science ou description populaire des inventions modernes, t. 4, Paris, Furne, Jouvet et Cie, (lire sur Wikisource), « La Ventilation », p. 349-414

Notes et références

- Notes

- En 1734, M. Désaguliers invente une machine appelée roue centrifuge ; elle a sept pieds de diamètre et un pied d'épaisseur, elle est divisée en douze séparations dirigées de la circonférence vers le centre qu'elle n'approche cependant qu'à la distance de neuf à dix pouces ; cette roue est reçue dans une boîte cylindrique et traversée par un axe au moyen duquel un homme la met en mouvement. Un tuyau d'aspiration établit une communication entre l'espace circulaire voisin de l'axe et celui dont on veut renouveler l'air en sorte que ce fluide entraîné par 1a révolution de la roue se porte à la circonférence et s'échappe par un tuyau de décharge en même temps que de nouvel air arrive dans la salle par une ouverture faite dans cette intention. Dans M. De Fontenay, Manuel des constructions rustiques, ou guide pour les constructions rurales, 1836. Lire en ligne [archive].

- Références

- Avis de l’Agence française de sécurité sanitaire de l’environnement et du travail Relatif à « l’évaluation du risque sanitaire pour l’homme lié à la présence de virus Influenza pandémique dans l’air des bâtiments et sa diffusion éventuelle par les dispositifs de ventilation », Saisine Afsset no 2006/003 [archive] (Rapport demandé en 2006 par Didier Houssin, délégué interministériel à la lutte contre la grippe aviaire, et publié après des tests en bureaux témoins du laboratoire d’essai du Centre scientifique et technique du bâtiment (CSTB) et deux ans d’expertise par un groupe de dix experts nationaux dont les travaux ont été relus et évalués par les comités d’experts spécialisés « air » et « eau » de l’Afsset).

- (en) Lewis G. Harriman II Douglas Kosar, Dehumidification and Cooling Loads From Ventilation Air

- V. C. Joly, Traité pratique du chauffage, de la ventilation, et de la distribution des eaux dans les habitations particulières : à l'usage des architectes, des entrepreneurs, et des propriétaires, 1869. Lire en ligne [archive].

- L'usage du verre dans l'architecture romaine, Pascal Vipard, maître de conférences d'Antiquités Nationales, université de Nancy 2.

- Hippocrate, Traité des airs des eaux et des lieux, 460 av. J.-C.

- [Agricola 1556] (la + en) Georg Agricola, Herbert Hoover et Lou Henry Hoover, De re metallica, Translated from the First Latin Edition of 1556, New York, Dover Publications, , sur archive.org (lire en ligne [archive]). Traduction française par A. France-Lanord (1992), éd. Gérard Kloop, Thionville.

- Samuel Sutton, Nouvelle méthode pour pomper le mauvais air des vaisseaux, 1749. Lire en ligne [archive].

- Edouard Mailly, Essai sur les institutions scientifiques de la Grande-Bretagne et de l'Irlande, F. Hayez, 1867.

- Eugène Péclet, Traité de la chaleur, considérée dans ses applications, D. Avanzo et Ce, 1844. Lire en ligne [archive].

- Maxime Vernois, Traité pratique d'hygiène industrielle et administrative, chez J. B. Baillière et Fils, 1860.

- Jean-Baptiste Fressoz, La Controverse du gaz d'éclairage, Pour la science, no 405, juillet 2011.

- Mémoires et compte-rendu des travaux, Société des ingénieurs civils de France, 1868. Livre numérique Google [archive].

- Louis Figuier, Les merveilles de la science, ou Description populaire des inventions modernes, Furne, Jouvet et Cie., 1870. Lire en ligne [archive].

- « Guide » [archive] (consulté le )

- James Atkinson, Yves Chartier, C. L. Pessoa-Silva, P. Jensen, Y. Li et W. H. Seto, Utilisation de la ventilation naturelle pour lutter contre les infections en milieu de soins, World Health Organization, 2011. Lire en ligne [archive].

- Les conseils de vos médecins pour votre air intérieur [archive] « Copie archivée » (version du 8 novembre 2018 sur l'Internet Archive).

Voir aussi

Articles connexes

- Renouvellement de l'air intérieur

- Aérage

- Chauffage

- Plomberie

- Climatisation

- Ventilation mécanique contrôlée

- Badgir

- Ventilation industrielle

- Portail de l’électricité et de l’électronique

- Portail de l’énergie

-

Cheminée

Cheminées dépassant le faîtage des bâtiments à Newcastle upon Tyne (Angleterre).Cheminées traitées comme élément décoratif (ici style Tudor typique).Breamore House, manoir élisabéthain (Hampshire).La cheminée est le conduit (conduit de fumée), construit en dur, qui véhicule et confine les fumées, la vapeur d'eau, les autres gaz de combustion, éventuellement toxiques, d'un quelconque foyer, ouvert ou fermé, brûlant, afin de les évacuer ou, plus rarement, de les traiter. Le terme « cheminée » désigne également, par métonymie, l'âtre, le foyer.

Définitions

Vue de l'extérieur, la cheminée désigne couramment la « souche », l'extrémité du conduit à fumée dépassant du toit du bâtiment. Ce terme désigne aussi, surtout dans l'industrie, un édifice séparé du reste des constructions, un corps de construction complètement autonome.

Les navires, les locomobiles et les locomotives à vapeur ont en ce sens des cheminées, même si ce sont de simples tuyaux cylindriques : la combustion est faite à l’extérieur du moteur avec du combustible dans une chambre ou un foyer de combustion. Pour les véhicules à moteur à combustion interne, c'est plutôt un pot d'échappement ou une tuyère.

Les cheminées industrielles sont de hautes constructions de forme spécifique conçues pour évacuer les fumées des foyers d'usine ou d'équipements collectifs. On désigne maintenant, par analogie, les aéroréfrigérants qui servent dans des centrales nucléaires pour évacuer la vapeur d'eau de refroidissement des circuits secondaires de chaudière.

D'un point de vue intérieur, la cheminée n'est autre que l'âtre, la cheminée ornementale d'appartement, c'est-à-dire l'espace aménagé autour du foyer ouvert comportant sur son dessus une hotte et dont le fond porte une plaque de cheminée, appelée aussi « taque » ou « contrecœur » et destinée à capter la chaleur. Cet espace autrefois important se distingue en ce sens des fours, des fourneaux ou des poêles.

Origine

Cheminée exposée et conduit de cheminée dans un château médiéval.Le terme cheminée vient du bas latin caminata1, par le mot latin caminus signifiant « âtre », lui-même emprunté au grec kaminos de même sens et appartenant à la famille du verbe grec kaiein, « brûler ». Le mot féminin cheminee (sic) est attesté en 1138 par écrit en ancien français dans La Vie de saint Gilles.

La cheminée désigne à l'origine une construction technique en dur qui reçoit le matériau combustible, permet sa combustion par flamme ainsi que le conduit permettant d'évacuer ou d'utiliser les fumées et autres gaz brûlés. Par métonymie, le mot cheminée va par la suite désigner deux choses :

- l'endroit autrefois ouvert où l'on fait le feu, appelé également « âtre » ou « foyer » ;

- le conduit vertical qui le prolonge ainsi que tout autre conduit de dégagement des gaz de combustion.

Histoire

Cheminée à l'ère industrielle

Les cheminées industrielles sont des points hauts sur lesquels on a souvent posé des paratonnerres.Le paysage industriel a pour figure principale la cheminée industrielle, symbolisée en beffroi du travail, qui est très haute et domine les sites. Les cheminées ont fait partie de la Révolution industrielle, signe de puissance et organe publicitaire (le nom de l'entreprise était parfois écrit dans le corps de cheminée avec des briques de couleur ; la cheminée a aussi servi de signal — sorte de clocher — des premières cités ouvrières humanistes où la cheminée d'usine ainsi que le portail se trouvaient dans l'arrangement dans leur urbanisation), avec le développement de la mécanisation dans la fabrication nécessitant de l’énergie qui ne pouvait plus provenir des moulins à eau ou à vent par la localisation des usines. Lorsque le coke a remplacé le charbon de bois, la capacité en production du fer par la sidérurgie a été multipliée. Cette puissance avait pour contrepartie une pollution aérienne non maîtrisée très nuisible à la santé de la populationnote 1 et qui enlaidissait les villes par la noirceur des suies collées sur les façades d’immeubles par l’humidité. Cet aspect négatif a provoqué l’essor jugé moderne du chauffage tout électrique des 30 dernières années du XXe siècle. Les villes furent nettoyées en France dans la décennie 1960 et le smog des cheminées disparut par l’abandon généralisé de la filière houille (et les souches des cheminées devinrent le support des antennes de télévision dont elles se hérissèrent).

À partir du début du XXe siècle, la réglementation des rejets dus à l’activité professionnelle a été de plus en plus contraignante de façon à préserver la santé de la population en ce qui concerne les rejets des fumées et gaz produits par les processus industriels.

Généralités

Les aménagements sont destinés à utiliser un feu dans un édifice, sans risque majeur d'incendie, pour assurer le chauffage, la cuisine, et d’autres activités (souvent professionnelles).

Le combustible brûle dans un foyer ouvert, un insert (foyer fermé), un poêle, une cuisinière, un chauffe-eau, un four, ou une chaudière, en ce qui concerne les habitations et locaux artisanaux.

La nature des matériaux utilisés pour la cheminée dépend du combustible. Dans les immeubles anciens, les cheminées sont montées en briques réfractaires. Les conduits à fumées des appareils à gaz actuels requièrent pour résister à l’agressivité des rejets un chemisage, un tubage, si la cheminée n’est pas une structure métallique. Dans les immeubles modernes, ces conduits particuliers se connectent sur des extracteurs en toiture.

Pour les usines, les chaufferies urbaines, les cheminées sont utilisées pour les rejets soumis à réglementation des fumées et gaz produits par les processus industriels. Le niveau de pollution constaté dans les environs les oblige par périodes à utiliser des combustibles différents de ceux en usage habituellement.

L'évacuation des fumées et gaz repose sur la différence de densité des gaz chauds par rapport à l'air : elle nécessite une ventilation de la pièce et doit au besoin être soutenue par des dispositifs techniques (les dimensions de tous les éléments sont cruciales et en fait complexes). La cheminée d'appartement, pour fonctionner naturellement, ne doit pas être placée dans un immeuble qui dispose de la ventilation mécanique contrôlée (VMC).

La dépression qui fait l’aspiration dans une cheminée est aussi obtenue, même sans combustion, par le vent entraînant par une sorte d’engrènement un courant d’air dans le tube dont l’orifice est correctement positionné. De plus, la toiture suivant sa forme soumise au vent peut faire déflecteur ou réflecteur selon la direction du flux. Il peut se produire alors une détente ou une compression sur le conduit à fumées selon les positions relatives toit et souche de cheminée, ce qui se traduit en aspiration supplémentaire ou en refoulement. En conséquence, les règles DTU imposent que l’orifice de la cheminée soit à la hauteur du faîtage pour toit à fortes pentes, le dépasse de 0,40 m pour toit à faibles pentes, dépasse de 1 m l’acrotère d’un toit terrasse et qu’il n’y ait pas d’obstacle par un corps de bâtiment ou autre qui dépasse la souche dans une distance de 8 m. Une dépression inopportune due à un vent fort peut être maîtrisée à l’aide des fentes horizontales ou quelquefois verticales de la lanterne disposée au sommet qui favorisent un flux plus régulier. Mais l’aspiration peut être aussi augmentée par l’effet Venturi donné par l’embout posé sur la souche.

Une précaution d’indépendance du conduit non tubé qui doit être jointif mais non dépendant de la structure doit être prise avec la liaison au bâti par des viroles pour éviter les effets de fissuration de l’immeuble par la dilatation différentielle verticale pendant le chauffage de la chaufferie. Les conduits à fumée sont construits pour les constructions basses avec des boisseaux, portions empilables de tube rectangulaire en céramique ou en béton. Pour éviter tout problème de tirage, le conduit doit avoir une surface d'au moins 1/7 de la surface du foyer.

La fumée dépose de la suie dans le conduit. Le conduit doit donc avoir, pour l’éviter, une surface intérieure la plus lisse possible et la plus verticale possible. Le dévoiement du conduit se fait donc avec un angle dont la valeur maximale dépend de la hauteur totale du conduit à fumée, néanmoins il ne doit pas dépasser un angle de 45 degrés2 qui conduit à une accumulation de suie excessive. Une cheminée doit être ramonée aussi souvent que nécessaire pour éviter une diminution du tirage ou les « feux de cheminée ». Les attestations annuelles de ramonage peuvent être exigées par les compagnies d'assurance en cas de sinistre.

En matière d'efficacité énergétiquenote 2, les cheminées domestiques peuvent être équipées de divers systèmes de récupération de chaleur chauffant de l’air ou de l’eau qui est ensuite répartie dans les pièces par des gaines puis des bouches d’air ou par des radiateurs.

La mitoyenneté des bâtiments de hauteur différente aboutit à des règles de propriété et d’accès concernant les conduits de cheminée qui s’appuient de droit sur le mur voisin qui dépassent le faîte du toit de l’édifice ayant une cheminée.

Les artisans dont la compétence est la construction et restauration des cheminées sont appelés les « âtriers » ou « maîtres-âtriers ».

Vocabulaire

Souches de cheminées

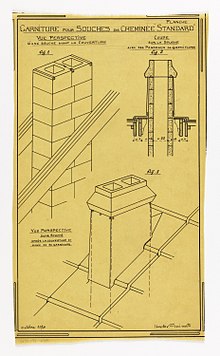

Hector Guimard, garniture pour souche de cheminée standard (octobre 1920).Mitre

Les souches sont un des éléments de l'architecture des toits, par exemple celui du château de Chambord classique et de la Casa Milà moderne.

Sa fonction principale, le réglage de la régularité du tirage, est obtenue par les embouts au-dessus du couronnement qui évitent aussi les nidifications : les mitres en céramique, les bonnets coniques en métal, les lanternes en béton modernes ou anciennes en céramique, les dalles sur potelets, les tournevents ou gueule de loup qui augmentent le tirage en orientant l’orifice comme une girouette, les tabourins (petits moulins métalliques régulant le tirage par la rotation au vent), les tés qui privilégient une direction et font parfois un effet Venturi.

- Cheminée florentine : tous les conduits à fumée individuels débouchent dans un gros conduit final circulaire.

- Cheminée alsacienne : elle comporte le support du nid de cigogne.

- Cheminée sarrasine en Bresse et cheminée aragonaise : types identiques où les souches sont le prolongement d’un manteau en dôme.

Typologie

Cheminées d'usine

Marine

La ou les cheminées (ou tuyaux) des bateaux constituent l'enveloppe qui renferme et protège les conduits d'évacuation des fumées de combustion des machines.

Galeries

-

Kirlangiç kubbe, Grande Mosquée d'Erzurum (tr) (Turquie)

-

Cheminée de la Cuisine Haute, Palais des papes d'Avignon

-

Cheminée de cuisine, Couvent de Saint-Antoine de Paraguaçu (pt), Cachoeira (Bahia) (Brésil)

-

Restes de cheminée, Comté d'Augusta (Virginie, États-Unis)

-

Souches et Mitres, Casa Milà, Antoni Gaudí (Barcelone, 1910)

-

Palais Güell (Barcelone), Antoni Gaudí

Records

La plus haute cheminée du monde, de la centrale GRES-2 d'Ekibastuz, au Kazakhstan, culmine à 419,7 m.Annexes

Bibliographie

- Eugène Viollet-le-Duc, Dictionnaire raisonné de l’architecture française du XIe au XVIe siècle, 1868, article Cheminée.

Articles connexes

- Âtre, Cuisine noire, Cantou

- Cheminée du Front de Seine

- Cheminée sarrasine

- Darbazi (en), construction à dôme pyramidal à ouverture circulaire3, d'origine ancienne (culture kouro-araxe). L'exemplaire de Chachkari est visible au musée ethnographique de Tbilissi. Il en existe en Anatolie, Afghanistan, en assemblage à queue-d'aronde.

- Laternendecke (de)

- Fausse cheminée

- Fonte

- Liste des plus hautes cheminées

- Ramoneur

Liens externes

- Description des différentes composantes d'une cheminée [archive], www.ikonet.com (consulté le ).

- Index des cheminées fermées proposées sur le marché français [archive], www.cheminee.net (consulté le ).

Notes et références

Notes

- Pollution de Londres 1962 : 340 décès.

- Le rendement passe de 10 % pour un foyer ouvert à 85 % pour un poêle brûlant du bois (voir Bois énergie).

Références

- (fr) Cet article est partiellement ou en totalité issu de l’article de Wikipédia en français intitulé « Âtre » (voir la liste des auteurs).

- Définitions lexicographiques [archive] et étymologiques [archive] de « Cheminée » (sens Prononc. et Orth.) dans le Trésor de la langue française informatisé, sur le site du Centre national de ressources textuelles et lexicales.

- « Arrêté du 22 octobre 1969 relatif aux conduits de fumée desservant des logements » [archive], www.legifrance.gouv.fr (consulté le 4 juin 2019).

- « Les maisons traditionnelles de Géorgie » [archive], maison-monde.com (consulté le 4 juin 2019).

-

Canalisation

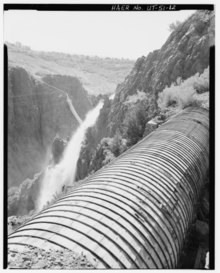

Conduite d'eau en bois, Ogden Canyon Conduit, Ogden, Comté de WeberAncienne canalisation, vestige de la machine de Marly à Bougival.Sections de canalisation enterrée.Une canalisation est un tuyau ou un canal1 destiné à l'acheminement de matières gazeuses, liquides, solides ou polyphasiques.

Il s'agit d'un tuyau, dont le diamètre nominal (DN) peut aller de 30 mm environ (un pouce un quart) pour des fluides spéciaux jusqu'à plus de 3 m pour les adductions d'eau.

Le terme pipeline est utilisé pour les conduites de fluides sous pression et sur de grandes distances.

Pour une canalisation de petit diamètre (< 30 mm environ), on parle de tuyauterie.

Différentes types de canalisations sont fabriquées et posées par des entreprises et corps de métiers spécialisés pour l'eau potable, le gaz, le pétrole, l'oxygène, l'hydrogène, les eaux résiduaires et dégouts et divers autres fluides, dont caloporteur ou porteurs de frigories, pour les réseaux de chaleur et les réseaux de froid. Il existe en France une organisation professionnelle dénommée « les Canalisateurs » (rassemblant environ 300 entreprises en 2019), membre de la Fédération nationale des travaux publics (FNTP)2.